что такое сплит тест

Что такое A/B-тестирование и как его проводить

Бизнес не стоит на месте – чтобы выжить, нужно развиваться. Если остановить этот процесс, проект начнет деградировать. Часто приходится что-то менять – расширять ассортимент, увеличивать рекламный охват аудитории, улучшать дизайн сайта, добавлять новый, повышать конверсию. Как узнать заранее, что принесут эти новшества?

Одни из инструментов, помогающий развитию веб-проектов – A/B-тестирование. С его помощью можно проверить свои гипотезы и экспериментально оценить предпочтения посетителей – чтобы принять решение о том, стоит ли что-то менять или лучше оставить как есть.

Рассказываем, как это работает.

Что такое A/B-тестирование

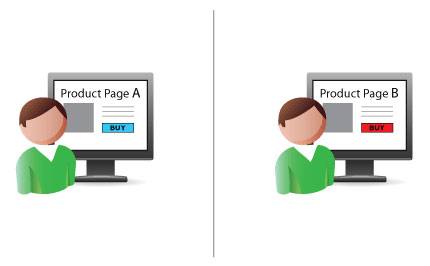

A/B-тестирование — это маркетинговый метод, использующийся для оценки и управления эффективностью веб-страницы. Этот метод также называется сплит-тестированием (от англ. split testing — раздельное тестирование).

A/B-тестирование позволяет оценивать количественные показатели работы двух вариантов веб-страницы, а также сравнивать их между собой. Также сплит-тестирование помогает оценивать эффективность изменений страницы, например, добавления новых элементов дизайна или призывов к действию. Практический смысл использования этого метода заключается в поиске и внедрении компонентов страницы, увеличивающих ее результативность. Обратите внимание еще раз, A/B-тестирование — это прикладной маркетинговый метод, с помощью которого можно влиять на конверсию, стимулировать сбыт и повышать прибыльность веб-проекта.

Сплит-тестирование начинается с оценки метрик существующей веб-страницы (A, контрольная страница) и поиска способов ее улучшения. Например, вы создали интернет-магазин. Представьте себе посадочную страницу этого магазина с коэффициентом конверсии 2%. Маркетолог желает увеличить этот показатель до 4%, поэтому планирует изменения, которые помогут решить эту задачу.

Допустим, специалист предполагает, что изменив цвет конверсионной кнопки с нейтрального голубого на агрессивный красный, он сделает ее более заметной. Чтобы проверить, приведет ли это к увеличению продаж и росту конверсии, маркетолог создает усовершенствованный вариант веб-страницы (B, новая страница).

С помощью инструментов для проведения сплит-тестирования эксперт в случайном порядке разделяет трафик между страницами A и B на две приблизительно равные части. Условно говоря, половина посетителей попадает на страницу A, а вторая половина на страницу B. При этом маркетолог держит в уме источники трафика. Чтобы обеспечить валидность и объективность тестирования, необходимо направить на страницы A и B по 50% посетителей, пришедших на сайт из социальных сетей, естественного поиска, контекстной рекламы и т.п.

Собрав достаточно информации, маркетолог оценивает результаты тестирования. Как сказано выше, коэффициент конверсии страницы A составляет 2%. Если на странице B этот показатель составил 2,5%, значит изменение конверсионной кнопки с голубого на красный цвет действительно увеличило эффективность лэндинга. Однако показатель конверсии не достиг желаемых 4%. Поэтому маркетолог дальше ищет способы совершенствования страницы с помощью A/B-тестирования. При этом в качестве контрольной выступит уже страница с красной конверсионной кнопкой.

Что тестировать

Как отмечалось выше, сплит-тестирование — это прикладной метод, позволяющий влиять на различные метрики сайта. Поэтому выбор объекта тестирования зависит от цели и задач, которые ставит перед собой маркетолог.

Например, если показатель отказов посадочной страницы составляет 99%, при этом большинство посетителей покидает лэндинг в течение 2-3 секунд после «приземления», стоит задуматься об изменении визуальных компонентов страницы. С помощью A/B-теста маркетолог может найти оптимальный вариант макета страницы, выбрать привлекательную цветовую гамму и изображения, использовать читабельный шрифт. А если перед маркетологом стоит задача увеличить количество подписок, он может попробовать изменить соответствующую конверсионную форму. Сплит-тест поможет специалисту выбрать оптимальный цвет кнопки, лучший вариант текста, количество полей в форме подписки или ее расположение.

Чаще всего маркетологи тестируют следующие элементы веб-страниц:

Какие инструменты сплит-тестирования использовать

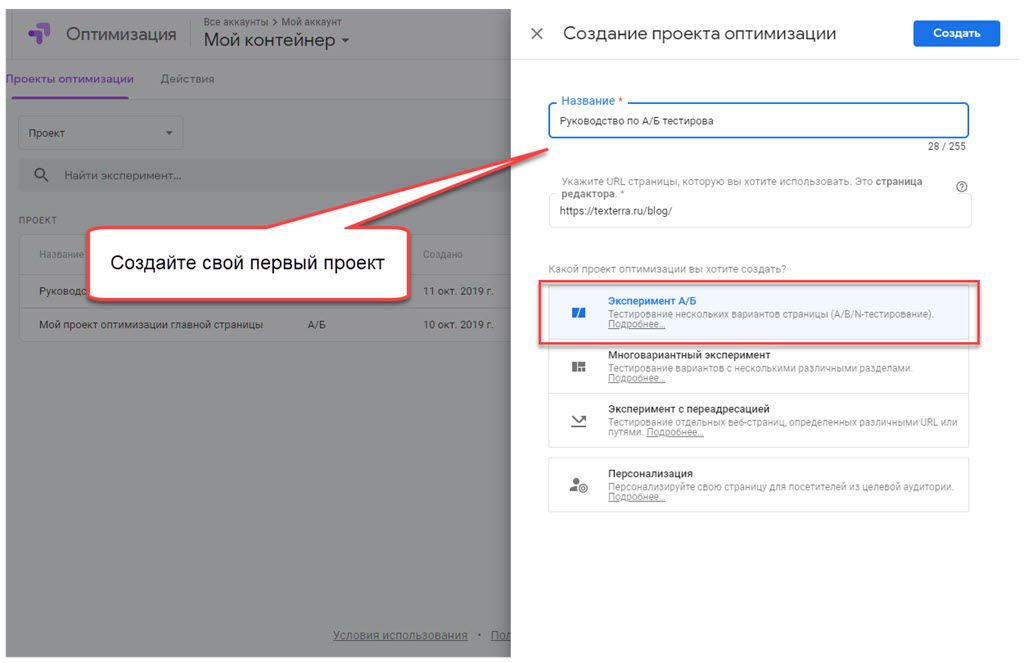

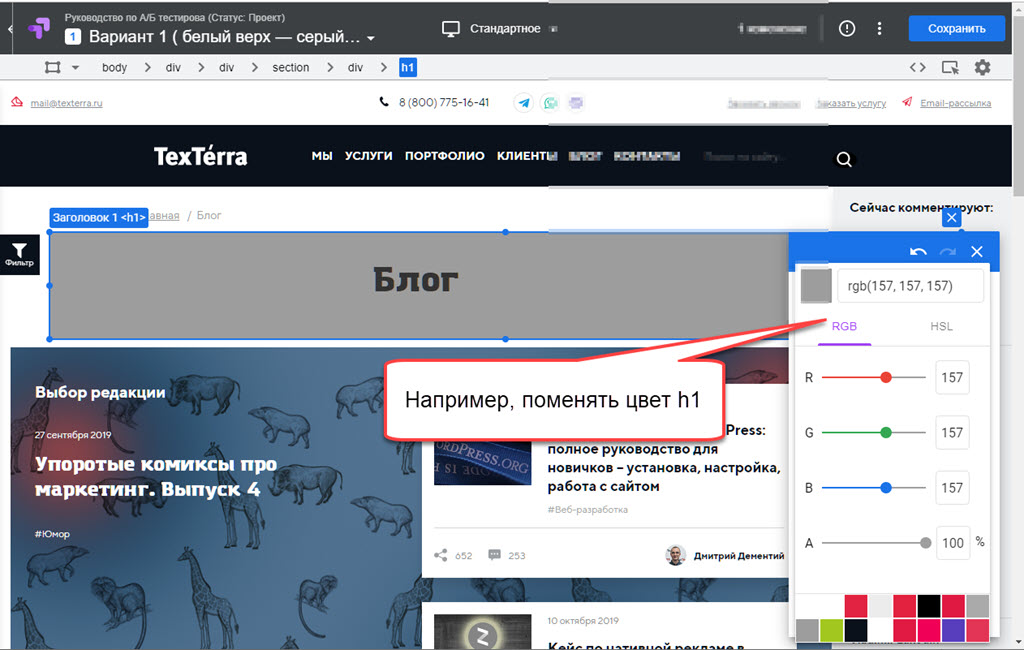

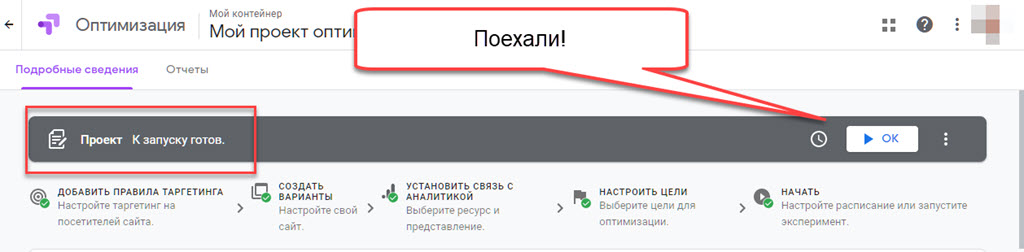

Чтобы выполнить A/B-тестирование, маркетологу необходимо воспользоваться одним из специализированных инструментов. Один из наиболее востребованных – сервис Google «Оптимизация» (до августа 2019 назывался Content Experiments), который является теперь частью новой платформы для маркетологов Google Marketing Platform. С его помощью можно тестировать элементы страниц, включая заголовки, шрифты, конверсионные кнопки и формы, изображения и т. п. «Оптимизация» бесплатна для малого бизнеса и в этом ее большое преимущество по сравнению с конкурентами.

Также можно использовать для проведения сплит-тестирования следующие инструменты:

Как провести A/B-тестирование с помощью Google Optimize

Сервис «Оптимизация» Google Marketing Platform позволяет одновременно проверить эффективность пяти вариантов страницы. Используя его, можно проводить A/B/N-тестирование, которое отличается от стандартных A/B-экспериментов проверкой сразу несколько гипотез вместо двух.

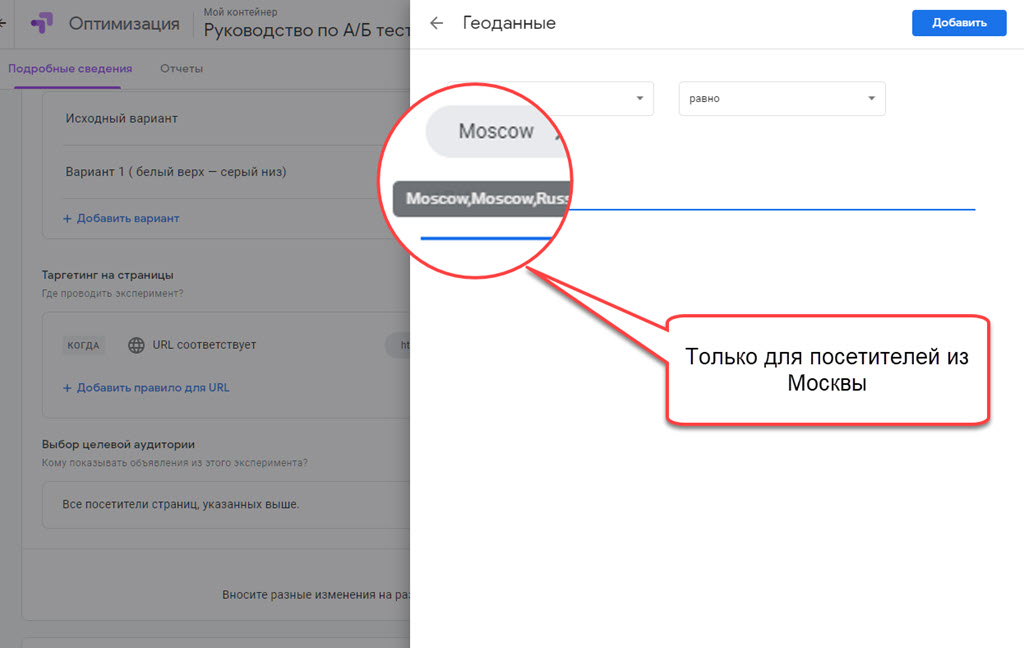

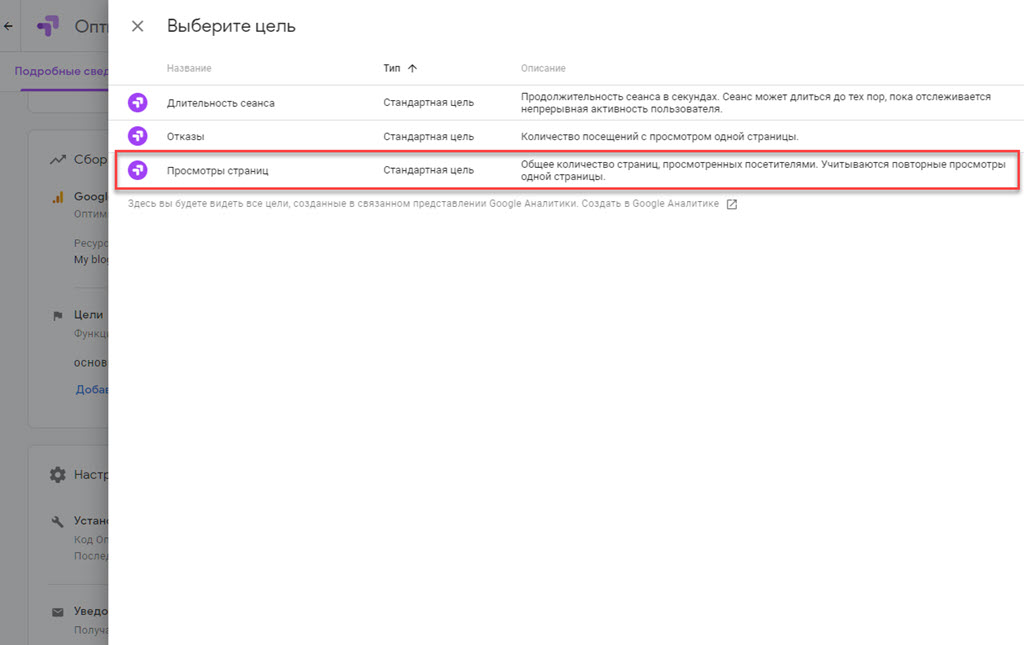

Маркетолог имеет возможность самостоятельно определять долю трафика, участвующего в тестировании. Минимальная продолжительность теста составляет две недели, максимальная ограничена тремя месяцами. Результаты можно наблюдать в личном кабинете или получить по e-mail.

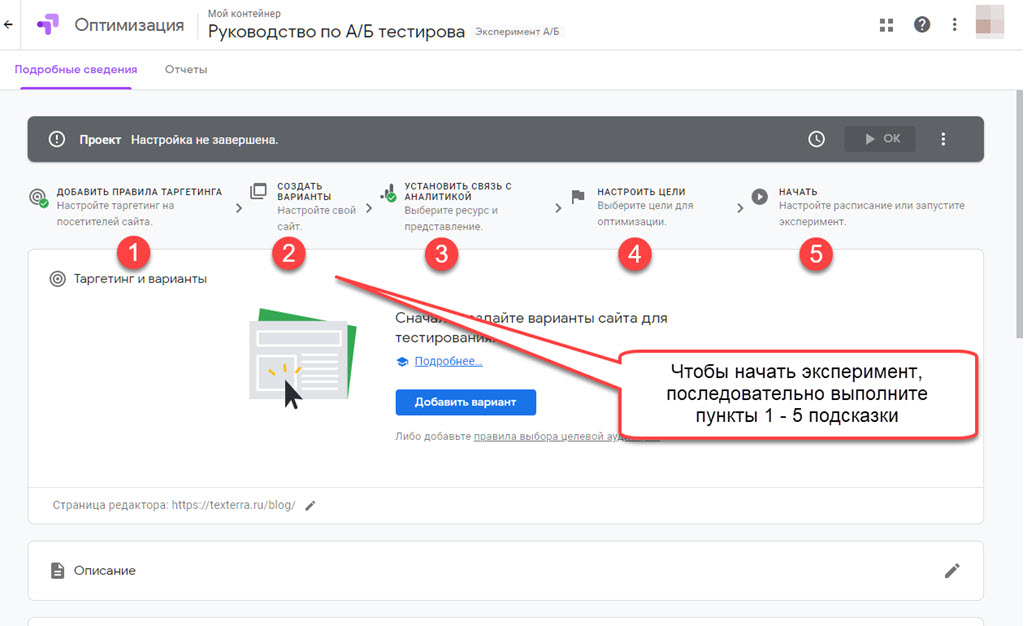

Чтобы провести сплит-тестирование с помощью «Оптимизации» сделайте следующее:

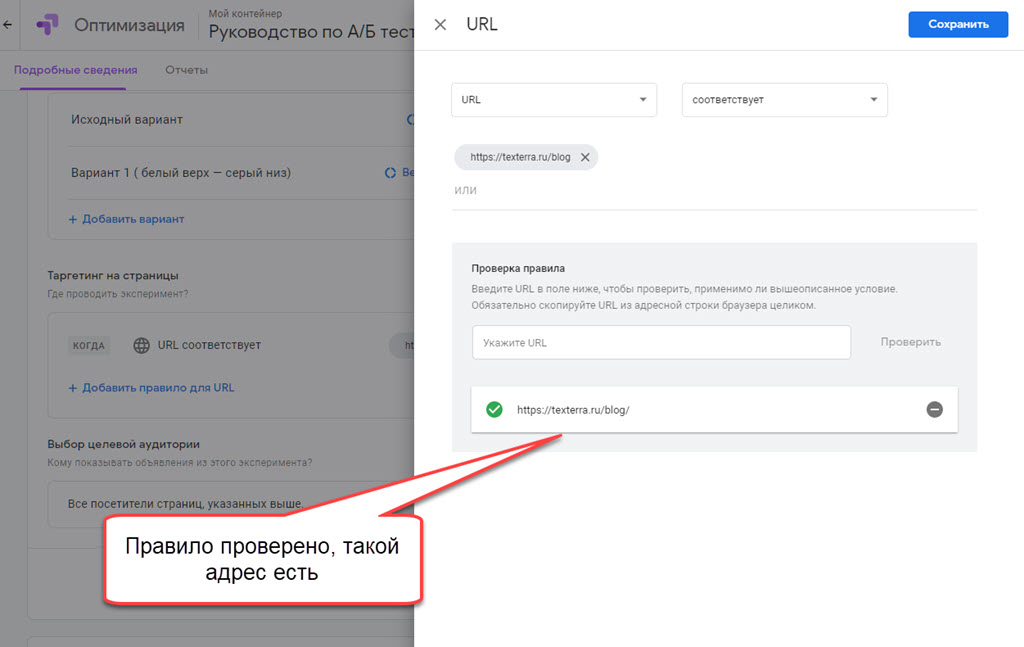

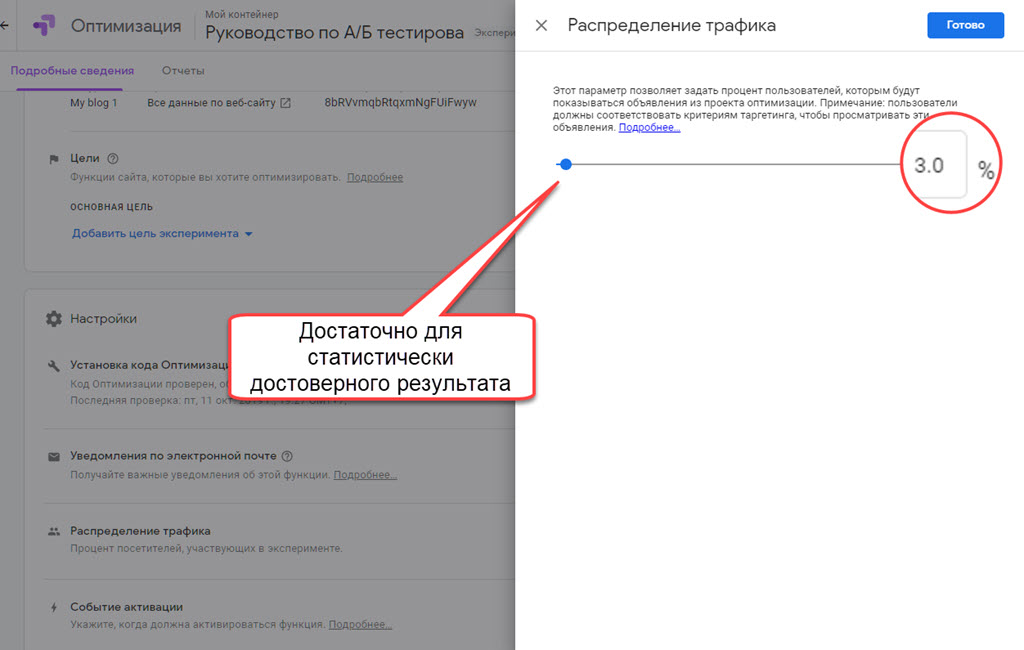

Еще важный момент – определить, какая часть трафика будет участвовать в эксперименте. По умолчанию используется все 100 %, а если у вас, как у «Текстерры», миллион уникальных посетителей в месяц – вполне хватить и 20–30 тысяч. А значит, выбираем 3 %.

Вы сможете оценить первые результаты тестирования через несколько суток после начала эксперимента. Чтобы следить за результатами тестирования, выберите соответствующий эксперимент в списке и перейдите на страницу отчетов.

Идеи, эффективность которых стоит обязательно проверить с помощью A/Б-тестирования

Мы уже говорили, что тестирование помогает увеличить эффективность веб-страниц. Чтобы этот метод принес результат, маркетолог должен генерировать идеи, способные позитивно влиять на те или иные метрики сайта. Нельзя просто брать какие-либо изменения с потолка, внедрять их и тестировать эффективность. Например, вряд ли метрики сайта изменятся, если вы просто решите изменить фон заголовка главной страницы, как в прошлом примере.

Маркетолог должен видеть способы улучшения страниц и понимать, почему они должны сработать. Cплит-тестирование просто помогает проверить предположения специалиста. Однако каждый маркетолог иногда оказывается в ситуации, когда все идеи проверены, а необходимого результата достичь не удалось. Если вы попали в такую ситуацию, попробуйте внедрить следующие изменения и проверить их эффективность:

Как и зачем тестировать разные варианты страниц

A/Б тестирование позволяет оценить эффективность изменений веб-страниц. Этот маркетинговый метод имеет прикладное значение. Он позволяет практически постоянно совершенствовать страницы, улучшая различные метрики.

Чтобы протестировать то или иное изменение, необходимо создать новый вариант страницы и сохранить старый. После этого следует воспользоваться одним из сервисов для проведения экспериментов, например, «Оптимизацией» Google. Оценку результатов можно проводить как минимум через две недели после его запуска.

Кстати, экспериментальная проверка маркетинговых гипотез с помощью А/Б тестирования – одна из составляющих работ по комплексному продвижению в интернете от TexTerra.

Сплит-тестирование от А до Ю

Сплит-тестирование заслуженно считается самым надежным инструментом оптимизации конверсии. Любое изменение на сайте необходимо проверить. Интуитивно понять, каким будет результат ваших правок, невозможно. При этом необходимо учесть ряд важных моментов: какие элементы тестировать, сколько времени, на каком трафике.

В этой статье вы узнаете ответы на 10 часто задаваемых вопросах о сплит-тестировании.

Когда необходим тест?

Как правило, у маркетолога несколько версий заголовков, тематического изображения, лид-формы, цвета кнопки CTA и т.д. Это только основные варианты, а на практике целевая страница подобна пазлу с сотнями вариантов сборки. Тесты необходимы всегда. Конечно, если вы заинтересованы в повышении конверсии.

Нет предела совершенству, и с текущего показателя 1% можно спокойно «прыгнуть» до 10%. Лидеры рынка берут планку в 20-25%. При том, что ничем сверхъестественным они не занимаются. Просто тестируют. Постоянно.

Безусловно, в начале следует четко поставить цель – что вы хотите изменить и какого результата добиться. Что это даст посетителям страницы, как облегчит совершение целевого действия? Помните правило арифметики: «От перестановки мест слагаемых сумма не меняется». Поэтому тестируемые изменения должны быть значимыми.

Сколько элементов следует тестировать?

Дело в том, что у вас должна быть полная ясность: как изменение конкретного блока повлияло на конверсию. При тесте двух и более элементов это невозможно.

Сколько версий страницы запускать одновременно?

Еще один количественный вопрос: у вас есть 4 версии заголовка, как их тестировать? Опубликуйте одновременно 2 варианта, затем еще 2 и в конце сравните победителей каждой пары. Как на чемпионате мира – игра на выбывание.

Но если у вас достаточное количество трафика и времени на эксперимент, можно запустить мультитестинг. Сразу 4 версии и более. Важно, чтобы они отличались только по одному параметру.

Какой трафик необходим для достоверных результатов?

Большинство экспертов рекомендуют 2,5-3 000 конверсий на каждую из версий. Для многих бизнесов это абсурдно, потому что придется ждать результатов полгода, а может, и больше. Сплошь и рядом лендинги со 100 целевыми действиями в месяц. Представляете, сколько времени им потребуется на 3 000?

Дело даже не в количестве трафика, а в статистической значимости теста. Когда вероятность превосходства одного варианта над другим свыше 95%.

Мы уже рассматривали проблему оптимизации конверсии при низком трафике. Напомним, что сервис Yagla позволяет определить победителя уже при 20 достижениях цели благодаря методике «жадного» A/B тестинга.

Как A/B тест влияет на SEO?

Расхожее мнение о дурном влиянии сплит-тестирования на позиции в поисковиках совершенно беспочвенно. Поисковые роботы не воспринимают 2 версии страницы как дублированный контент. В конце концов у того же Google есть инструмент для экспериментов Website Optimizer.

Если уж совсем боитесь, закройте контент одной из версий тегом «noindex».

Когда останавливать тест?

Обычно инструменты A/B тестинга автоматически сигнализируют о достижении статистической значимости, которая является «финишной чертой». Ни в к коем случае не делайте выводов после 3-4 дней эксперимента.

Дело в том, что еще спустя еще несколько дней показатели могут выровняться. В конечном итоге нужно убедиться в четкой взаимосвязи результата с внесенными изменениями.

Что нужно тестировать?

В 95% случаев существенное повышение конверсии приносят правки следующих элементов:

Также значимы: объем текстовых блоков; наличие или отсутствие видео; наличие и качество отзывов и прочих социальных доказательств.

Что еще проверить с помощью сплит-тестов, кроме целевой страницы?

Вы можете проверить:

Таким образом, тестирование касается двух стратегий маркетинга:

С помощью каких сервисов проводится сплит-тест?

Мы рекомендуем тестирование с помощью нашего сервиса Yagla для тех, у кого настроена контекстная реклама. Он позволяет определить наиболее конверсионный вариант и при малом трафике, а изменение элементов происходит на одной и той же странице.

Также маркетологи используют эксперименты Google Analytics, Optimizely, ABTest.ru, VisualWebsiteOptimizer.

Как поделить тестовый трафик 50/50?

Для достоверности необходимо, чтобы каждый из вариантов получил одинаковое количество переходов. Тестовая платформа может поделить трафик поровну, а может, и нет. В частности, через контекстную рекламу идет очень неоднородный трафик. Так что, добиться нужной пропорции практически невозможно.

И здесь помогает Yagla: после минимальной статистики (от 20 конверсий) она прогнозирует победителя. В результате более эффективные варианты получают большее количество переходов.

Вместо заключения

Почему наш материал назван «Сплит-тестирование от А до Ю»? Тестирование – это целая наука. Причем, практическая наука с ежедневными изменениями. Даже в самом объемном материале невозможно предусмотреть все нюансы. Поэтому мы оставили последнюю букву алфавита для ваших собственных открытий.

Подводные камни A/Б-тестирования или почему 99% ваших сплит-тестов проводятся неверно?

«Горячая» и часто обсуждаемая сегодня тема оптимизации конверсии привела к безусловной популяризации А/Б-тестирования, как единственного объективного способа узнать правду о работоспособности тех или иных технологий/решений, связанных с увеличением экономической эффективности для онлайн-бизнеса.

За этой популярностью скрывается практически полное отсутствие культуры в организации, проведении и анализе результатов экспериментов. В Retail Rocket мы накопили большую экспертизу в оценке экономической эффективности от систем персонализации в электронной коммерции. За два года был отстроен идеальный процесс проведения A/Б-тестов, которым мы и хотим поделиться в рамках этой статьи.

Два слова о принципах A/Б-тестирования

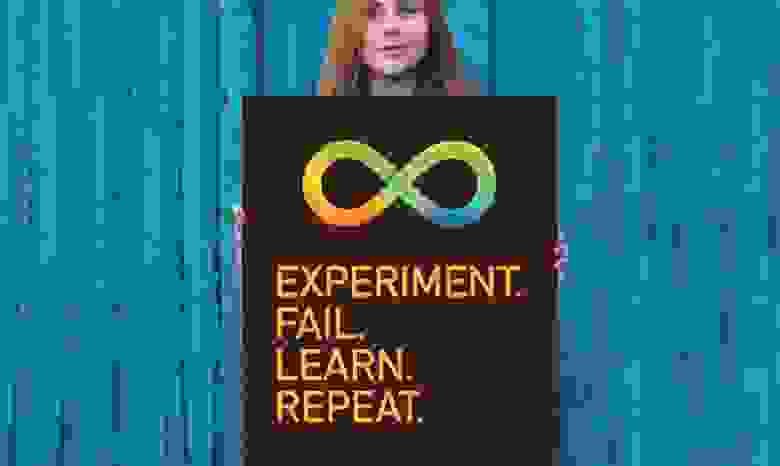

Прелесть этого подхода в том, что любую гипотезу можно проверить с помощью цифр. Нет необходимости спорить или опираться на мнение псевдоэкспертов. Запустили тест, замерили результат, перешли к следующему тесту.

Пример в цифрах

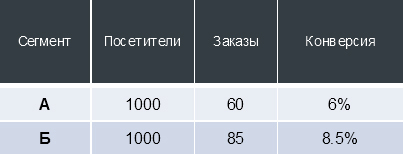

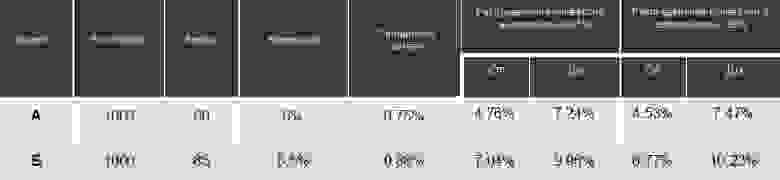

Для примера представим, что мы внесли на сайт какое-то изменение, запустили А/Б-тест и получили следующие данные:

Конверсия — не статичная величина, в зависимости от количества “испытаний” и “успехов” (в случае интернет-магазина — посещений сайта и оформленных заказов соответственно) конверсия распределяется в определенном интервале с расчетной вероятностью.

Для таблицы выше это означает, что если мы приведем еще 1000 пользователей на версию сайта “А” при неизменных внешних условиях, то с вероятностью 99% эти пользователи сделают от 45 до 75 заказов (то есть сконвертируются в покупателей с коэффициентом от 4.53% до 7.47%).

Сама по себе эта информация не слишком ценная, однако, при проведении А/Б-теста мы можем получить 2 интервала распределения конверсии. Сравнение пересечения так называемых “доверительных интервалов” конверсий, получаемых от двух сегментов пользователей, взаимодействующих с разными версиями сайта, позволяет принять решение и утверждать, что один из тестируемых вариантов сайта статистически достоверно превосходит другой. Графически это можно представить так:

Почему 99% ваших А/Б-тестов проводятся неверно?

Итак, с вышеописанной концепцией проведения экспериментов знакомо уже большинство, про неё рассказывают на отраслевых мероприятиях и пишут статьи. В Retail Rocket одновременно проходит 10-20 А/Б-тестов, за последние 3 года мы столкнулись с огромным количеством нюансов, которые часто остаются без внимания.

В этом есть огромный риск: если А/Б-тест проводится с ошибкой, то бизнес гарантированно принимает неверное решение и получает скрытые убытки. Более того, если вы ранее проводили A/Б-тесты, то скорее всего они были проведены некорректно.

Почему? Разберем самые частые ошибки, с которыми мы сталкивались в процессе проведения множества пост-тест анализов результатов проведенных экспериментов при внедрении Retail Rocket в интернет-магазины наших клиентов.

Доля аудитории в тесте

Пожалуй самая распространенная ошибка — при запуске тестирования не проверяется, что вся аудитория сайта участвует в нем. Довольно частый пример из жизни (скриншот из Google Analytics):

На скриншоте видно, что суммарно в тесте приняло участие чуть менее 6% аудитории. Крайне важно, чтобы вся аудитория сайта относилась к одному из сегментов теста, в противном случае невозможно оценить влияние изменения на бизнес в целом.

Равномерность распределения аудитории между тестируемыми вариациями

Недостаточно распределить всю аудиторию сайта по сегментам теста. Также важно проделать это равномерно по всем срезам. Рассмотрим на примере одного из наших клиентов:

Перед нами ситуация, при которой аудитория сайта делится неравномерно между сегментами теста. В данном случае в настройках инструмента для тестирования было выставлено деление трафика 50/50. Такая картина — явный признак того, что инструмент для распределения трафика работает не так, как ожидалось.

Кроме того, обратите внимание на последний столбец: видно, что во второй сегмент попадает больше повторной, а значит и более лояльной аудитории. Такие люди будут совершать больше заказов и исказят результаты тестирования. И это ещё один признак некорректной работы инструмента тестирования.

Чтобы исключить подобные ошибки через несколько дней после запуска тестирования всегда проверяйте равномерность деления трафика по всем доступным срезам (как минимум по городу, браузеру и платформе).

Фильтрация сотрудников интернет-магазина

Следующая распространенная проблема связана с сотрудниками интернет-магазинов, которые, попав в один из сегментов теста, оформляют заказы, поступившие по телефону. Тем самым сотрудники формируют дополнительные продажи в одном сегменте теста, в то время как звонящие находятся во всех. Безусловно, подобное аномальное поведение в конечном счете исказит итоговые результаты.

Операторов call-центра можно выявить с помощью отчета по сетям в Google Analytics:

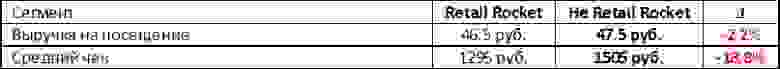

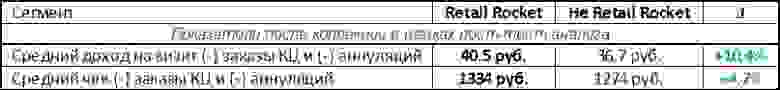

В любом случае, всегда можно выгрузить заказы из Google Analytics и присвоить им свойство “оформлен оператором” или “оформлен не оператором”. После чего построить сводную таблицу как на скриншоте, отражающую другую ситуацию, с которой мы сталкиваемся довольно часто: если взять выручку сегмента RR и Not RR (“сайт с Retail Rocket” и “без” соответственно), то “сайт с Retail Rocket” приносит меньше денег, чем “без”. Но если выделить заказы, оформленные операторами call-центра, то окажется, что Retail Rocket дает прирост выручки на 10%.

На какие показатели стоит обращать внимание при финальной оценке результатов?

Менеджер интернет-магазина настаивал на том, что если средний чек не изменился, то эффекта от сервиса нет. При этом полностью игнорируется факт общего прироста выручки благодаря системе рекомендаций.

Так на какой показатель стоит ориентироваться? Конечно, для бизнеса самое важное — это деньги. Если в рамках A/Б-теста трафик делился между сегментами посетителей равномерно, то нужный показатель для сравнения — выручка (revenue) по каждому сегменту.

В жизни ни один инструмент для случайного деления трафика не дает абсолютно равных сегментов, всегда существует отличие в доли процента, поэтому необходимо нормировать выручку по количеству сессий и использовать метрику “выручка на посещение” (revenue per visit).

Это признанный в мире KPI, на который рекомендуем ориентироваться при проведении A/Б-тестов.

Важно помнить, что выручка от оформленных на сайте заказов и “исполненная” выручка (выручка от фактически оплаченных заказов) — это абсолютно разные вещи.

Вот пример А/Б-теста, в котором система Retail Rocket сравнивалась с другой рекомендательной системой:

Сегмент «не Retail Rocket» побеждает по всем параметрам. Однако, в рамках следующего этапа пост-тест анализа были исключены заказы call-центра, а также аннулированные заказы. Результаты:

Пост-тест анализ результатов — обязательный пункт при проведении A/Б-тестирования!

Срезы данных

Работа с разными срезами данных — крайне важная составляющая при пост-тест анализе.

Вот еще один кейс тестирования Retail Rocket на одном из крупнейших интернет-магазинов в России:

На первый взгляд мы получили отличный результат — прирост выручки +16.7%. Но если добавить в отчет дополнительный срез данных «Тип устройства» можно увидеть следующую картину:

Очень важно в рамках пост-тест анализа строить отчеты как минимум в разрезе города, браузера и платформы пользователя, чтобы не упустить подобные проблемы и максимизировать результаты.

Статистическая достоверность

Следующая тема, которую необходимо затронуть, — статистическая достоверность. Принимать решение о внедрении изменения на сайт можно только после достижения статистической достоверности превосходства.

Для подсчета статистической достоверности конверсии существует множество online-инструментов, например, htraffic.ru/calc/:

Но конверсия — это не единственный показатель, определяющий экономическую эффективность сайта. Проблема большинства А/Б-тестов сегодня — проверяется только статистическая достоверность конверсии, что является недостаточным.

Средний чек

Выручка интернет-магазина строится из конверсии (доли людей, которые покупают) и из среднего чека (размера покупки). Статистическую достоверность изменения среднего чека посчитать сложнее, но без этого никак, иначе неизбежны неверные выводы.

На скриншоте продемонстрирован очередной пример A/Б-теста Retail Rocket, при котором в один из сегментов попал заказ на сумму более миллиона рублей:

Этот заказ составляет почти 10% от всей выручки за период проведения теста. В таком случае, при достижении статистической достоверности по конверсии можно ли считать достоверными результаты по выручке? Конечно, нет.

Время проведения теста

И напоследок, всегда обращайте внимание на то, когда вы запускаете тест и как долго он длится. Старайтесь не запускать тест за несколько дней до крупных гендерных праздников и в праздничные/выходные дни. Сезонность также прослеживается на уровне получения зарплат: как правило, это стимулирует продажи дорогих товаров, в частности, электроники.

Кроме того, существует доказанная зависимость между средним чеком в магазине и временем принятия решения до покупки. Проще говоря, чем дороже товары — тем дольше их выбирают. На скриншоте пример магазина, в котором 7% пользователей до покупки размышляют от 1 до 2 недель:

Если на таком магазине проводить А/Б-тест меньше недели, то в него не попадет около 10% аудитории и влияние изменения на сайте на бизнес однозначно оценить невозможно.

Вместо вывода. Как провести идеальный А/Б-тест?

Итак, для исключения всех описанных выше проблем и проведения правильного A/Б-теста нужно выполнить 3 шага:

1. Разделить трафик 50 / 50

Сложно: с помощью балансировщика трафика.

Просто: воспользоваться open source библиотекой Retail Rocket Segmentator, которую поддерживает команда Retail Rocket. За несколько лет тестов нам не удалось решить описанные выше проблемы в инструментах вроде Optimizely или Visual Website Optimizer.

Цель на втором шаге: не получить победителя, т.е. в двух сегментах с одинаковыми версиями сайта не должно быть разницы по ключевым показателям.

Делитесь своими кейсами проведения A/Б-тестов в комментариях!