Что такое поисковый спам

Что такое поисковый спам в SEO

Спамдексинг (spamdexing) — это несколько способов манипулирования SERP. Поисковый спам в Seo привлекает тем, что позволяет быстро достичь нужных высот в продвижении. Правда, на очень короткий срок и с риском загубить всю проводимую кампанию.

Что такое поисковый спам

Изначально английское слово spam означало получение нежелательных писем, чаще рекламного характера, к себе на почту. Со временем так стали называть все сообщения, которые выглядят неестественно и имеют намерение получить выгоду или смошенничать.

Веб-спам также имеет под собой замысел обмануть, но уже Гугл или Яндекс. Это делается различными способами. Например, чёрными:

Или методами помягче:

Спамом поисковые системы могут посчитать и бездумную покупку ссылок веб-мастером. Пара-тройка неестественных линков — уже сигнал для алгоритмов. Фильтр последует обязательно, поэтому оптимизатору надо работать над получением естественных отсылок и рекомендаций. Гоняясь за количеством, а не качеством, оптимизатор часто покупает сотни бэков с заброшенных блогов, одностраничников, мусорных форумов и т. д.

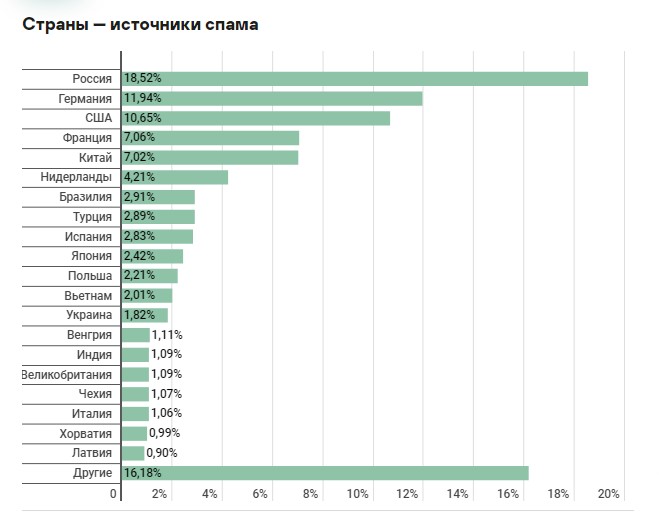

Постепенно web-spam становится всё более изощрённым. Об этом свидетельствуют статистические данные (включая обнаружение поисковыми серверами не только спама, но и фишинга):

Основными странами распространения являются Россия, Германия и США.

Очевидно, что при попадании фишингового сайта на первые три позиции SERP, количество его посещений увеличивается в несколько раз. Из-за этого пользователь не может найти полезную информацию и уходит. Получается, что борьба с мусорными сателлитами становится для поисковой системы крайне актуальной, вынужденной мерой.

Зачем и кому нужен

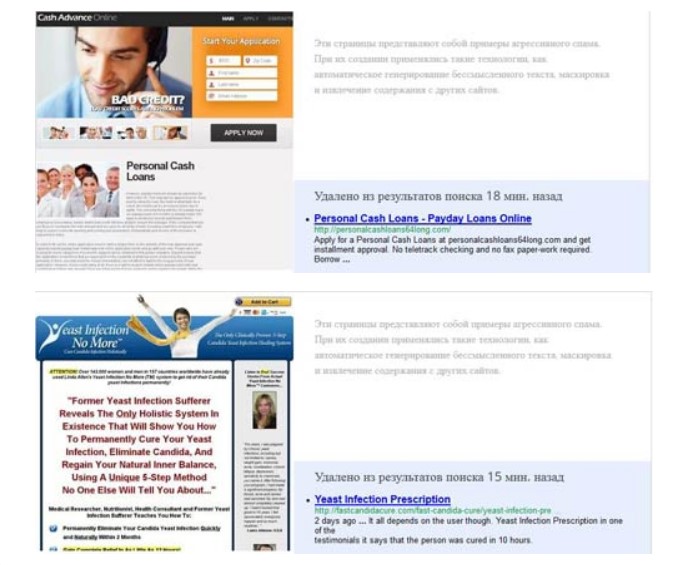

Все сайты с поисковым спамом (созданные специально) не имеют какого-либо информативного содержания и мало относятся к запросам юзера. Главная их задача — продвинуть основной ресурс. Некачественные страницы быстро определяются ПС и блокируются, поэтому большие средства (уникальный контент, дизайн, внешние ссылки) в них не вкладываются. Проще создать новый аналогичный лендинг со схожим дизайном и структурой.

Спамдексинг — отдельный вектор чёрной оптимизации. Применяется с целью манипуляции результатами выдачи, повышения трафика, лучшего ранжирования альфа-проекта и т. д.

Методы обнаружения поискового спама

Поисковые системы не любят спам, вводящий пользователей в заблуждение. Не найдя ответ на вопрос, они переходят на другие площадки или ещё хуже — в другую ПС. Поэтому алгоритмы находят и блокируют такие страницы.

Вот, как это обычно делается:

Одним из алгоритмов, выявляющих поисковый спам — является HITS. Он специально введён для ранжирования документов определённой тематической направленности и связан с конкретными запросами. На данный момент применяется ко всем сайтам для нахождения ядра (весомых страниц). Чтобы продвинуться в топ, «чёрный» Seo-шник обычно работает именно над авторитетными web-page.

Без применения специальных эвристик, поисковики затрачивали бы до седьмой части своих ресурсов на обнаружение спама. А это значительно ухудшает общее качества работы анализаторов, из-за чего под раздачу могут попасть хорошие и авторитетные сайты.

Ниже приведены основные методы, помогающие находить мусорные площадки:

Перечисленные эвристики применяются роботами в комплексе, иначе может возникнуть парадоксальная ситуация, когда web-spam помечаются качественные страницы. Наиболее эффективным становится объединённый метод анализа характеристик — точность вычисления в таком случае повышается практически до 100%.

Последствия использования поискового спама

Поисковые системы давно ведут борьбу со спамом, поэтому регулярно обновляют и совершенствуют собственные алгоритмы. Постоянно разрабатываются новые фильтры. За манипулирование выдачей наказывают по-разному, в зависимости от количества нарушений, степени вреда и т. п.

Например, перенасыщение статьи ключами может привести к падению позиций отдельной страницы (на которой опубликован материал), а за дорвеи — блокировке не только их, но и основного ресурса, а также всех связанных с ним сателлитов. Яша открыто об этом предупреждает и в подходящих случаях накладывает бан.

Гугл тоже располагает собственными фильтрами для борьбы со спамом. Однако в последнее время стал больше доверять асессорам — работникам, которые перепроверяют результаты.

| Фильтры Яндекса | |

| АГС | Введён с 2009 года, направлен на мусорные ресурсы с кучей Seo-ссылок, копипастом и низкой информативности. Как правило, обнуляет ИКС. |

| Баден-Баден | Основная задача — бороться с манипуляцией выдачи. Накладывается на сайты с переоптимизированными статьями. |

| МПК | Фильтр за малополезный контент, некорректную рекламу и спам. |

| Минусинск | Наказывает ресурсы за большое количество анкоров и неестественных ссылок. Понижает позиции страниц и ресурса в целом. |

| Бан за накрутку | Наказывают площадки, где замечена имитация действий посетителей. |

| Фильтры Гугла | |

| Panda | Назначение — косить сайты с малополезным контентом. Понижается позиция в выдаче, теряется органический трафик. |

| Supplemental Results | Недостаточно качественные, спамные страницы помещаются в дополнительный индекс, изначально скрытый от пользователей. |

| Penguin | За спам в комментариях, неестественные ссылки, переоптимизацию контента анкорами/безанкорами. |

| Фильтр за микроразметку | Накладывается в случае злоупотребления элементами мета-тегов. |

Выводы

Алгоритмы быстро находят поисковый спам, так как заинтересованы в качестве выдачи. Мусорные сайты обычно полностью блокируются, реже — накладывается фильтр на конкретные страницы.

Поисковый спам: классификация и методы устранения

Из этого материала вы узнаете:

Ежегодно количество интернет-сайтов стремительно растет, что ведет к сильному повышению конкуренции за место в ТОПе (особенно среди высокочастотных запросов). Чтобы продвигать собственные сайты в условиях жесткой конкуренции, веб-мастера и SEO-оптимизаторы пользуются разными методами. При этом поисковые системы частично или полностью запрещают многие из этих способов. В этой статье мы расскажем, что такое поисковый спам.

Что такое поисковый спам

Запрещенные методы оптимизации, которые иногда применяют некоторые веб-мастера, называют общим термином «поисковый спам». Название обусловлено тем, что поисковая выдача заспамливается веб-страницами с нерелевантным контентом из-за использования нечестных методов оптимизации. Проще говоря, поисковый спам — это процесс, когда пользователю выдаются страницы с содержимым, которые не соотносятся с его запросом (по его собственному мнению) и которые не должны присутствовать в ТОПе (по мнению поисковой системы).

Из-за присутствия спам-страниц в выдаче люди негативно относятся к поисковым системам и меньше им доверяют.

Общее значение спама — «интернет-мусор». Спамом называют рассылки коммерческих, информационных и других типов рекламных сообщений пользователям, которые не соглашались на их получение.

В Интернете спам распространяется по нескольким каналам:

Если углубиться, исторически термин «спам» означает SPicedhAM, или «острая ветчина» (в переводе с английского). По одной из теорий, после Второй мировой войны на складах компании Hormel Foods залежалось много консервов с острой ветчиной, которую употребляла армия США.

Чтобы как-то реализовать немного испорченный продукт, Hormel Foods начали активно его рекламировать. Компания обклеила здания, машины, витрины магазинов словом «SPAM», продвигала продукт по радио и в печатных СМИ. Но популярным «SPAM» стал только в «Летающем цирке Монти Пайтона» в 1969 году. Артисты шоу тогда представили пародию на столь агрессивную рекламу.

Рекомендуемые статьи по данной теме:

Этот случай связали с инцидентом 1986 года. В сети Usenet Дэйв Родес активно продвигал идею финансовой пирамиды, обещая, что вкладчики благодаря ей разбогатеют. Родес в огромных количествах рассылал сообщения, что вызвало у пользователей раздражение, а тексты писем начали называть «спамом».

В России термин «спам» возник во времена Августовского путча 19 августа 1991 года. Тогда руководитель компании «Релком» рассылал людям обращение Бориса Ельцина.

Вновь о спаме заговорили в 1993 году, когда администратор сети Usenet Ричард Депью нечаянно отправил на конференцию 200 сообщений.

В 1994 году компания Canter&Siegel поручила программисту разработку программы, рекламирующей в Usenet услуги. После такой рассылки интернет-пользователи быстро потеряли интерес к Usenet.

Сегодня спамом называют почтовые и электронные рассылки. Также термин используют в интернет-среде (спамдексинг).

Виды поискового спама

Каким бывает поисковый спам? Расскажем об основных его видах.

1. Употребление в тексте огромного количества ключевых слов и фраз

Ключевыми запросами может набиваться и текст, и описания к видео- и фотофайлам, метатеги и т. д.

Цель набивки — сделать так, чтобы алгоритм поисковых систем счел содержимое страницы соответствующим определенным ключевым запросам. Но на практике этот метод продвижения давно неэффективен. Оптимизаторы, которые его используют, скорее добьются бана для своего сайта, чем выведут его в ТОП.

2. Автоматический редирект

Процесс, при котором пользователи моментально перенаправляются с одной веб-страницы на другую. То есть человек заходит на один сайт, а система перенаправляет его на другой.

Часто человек не успевает заметить непосредственно редирект (поскольку это автоматический и очень быстрый процесс). Как правило, после редиректа пользователь попадает на веб-страницу с рекламным контентом, заспамленную ссылками.

Здесь для каждой продвигаемой страницы SEO-оптимизатор разрабатывает сразу две версии:

То есть клоаки — это разное содержание страниц для поисковиков и для простых людей.

Специальная программа фиксирует, кто именно посетил страницу — поисковый робот или пользователь. С учетом этого отображается определенный контент.

Оптимизация страницы для поисковых систем ведется очень тщательно. На странице нет ни одного лишнего элемента, зато есть множество ключей для поисковиков. Для пользователей страница выглядит абсолютно стандартно, имеет приятный дизайн и максимально удобную навигацию.

На первый взгляд, всем хорошо — и роботам, и людям. Но на самом деле, пользуясь клоаками, SEO-оптимизатор обманывает поисковую систему. А она в свою очередь видит это и банит веб-страницы, имеющие две версии.

Это полная замена контента веб-страницы сразу после ее успешной индексации в поисковых системах. Веб-мастер или SEO-оптимизатор, использующий этот способ, должен разместить на странице уникальное и качественное содержимое, повысить ее позиции и получить из поисковиков хороший трафик.

Далее, после планового update (периодического обновления поисковика), специалист полностью меняет контент на странице. Уникальный текст меняется на контент с бесчисленным количеством ключевых запросов и ссылок на продвигаемые веб-сайты.

Конечно, когда поисковые системы будут в очередной раз делать обновление, они выявят подмену и снизят позиции страницы в выдаче. Но до этого момента она будет собирать трафик (посещения) и какое-то время находиться в ТОПе.

5. Невидимые ссылки и текст

Есть разные способы скрыть от пользователей ссылки и текстовый контент на сайте. Например:

Пользователи не видят ни текст, ни ссылку. Однако текст и ссылка видны роботам, индексирующим поисковые системы.

Примеры поискового спама

Рассмотрим методы спама, влияющие на алгоритмы ранжирования.

При оценке релевантности текста поисковики учитывают, где на странице расположены запросы. Каждое такое расположение — это поле. Обычные текстовые поля для страницы — это тело документа, наименование веб-страницы (title), метатеги в HTML-заголовке и идентификатор инфоресурса (адрес веб-страницы).

Кроме того, указатели в тексте, связанные с урлами, указывающие на эту страницу и принадлежащие ей, — это анкеры текстового поля. Зачастую они достаточно полно описывают контент страницы. Выражения в текстовом поле веб-страницы используются для оценки, соответствует ли страница ключевому запросу (группе слов). Часто у разных полей разный вес. Выражения со спамом относятся к приему, определяющему содержание этих полей текста, чтобы сделать веб-страницы со спамом соответствующими определенным запросам.

Здесь выражения со спамом находятся в теле документа. Этот метод спама — самый простой и распространенный. Он такой же старый, как сами поисковики.

Results for Apartment Rent Moscow

Пластиковые окна, пластиковые окна пвх, пластиковые окна Internova, пластиковые окна KBE, пластиковые окна Tryba, пластиковые окна Rehau, пластиковые окна Veka

Спамеры всегда стремились к метатегам HTML, появляющимся в заголовке документа. Из-за значительного объема спама поисковики сейчас обращают все меньше внимания на эти теги или вообще их не замечают.

Вот простой пример спама ключей в метатегах:

Как и наименованию документа, поисковики придают большой вес анкерам (указателям) выражений в тексте, поскольку предполагают, что в них есть краткое содержание обозначенного документа. Поэтому выражения со спамом иногда включают в текст анкера HTML c гиперссылкой на страницу. Отличие этого метода спама от предыдущих в том, что выражения со спамом размещают не на самой главной странице, а на других, которые на нее ссылаются. Поскольку текст в анкерах индексируется для одной и для второй страницы, их спам влияет на ранжирование обеих страниц.

Элементарный пример спама анкеров текста:

«бесплатно, огромные скидки, дешево, недорого, дешево, бесплатно».

Иногда некоторые методы спама используют вместе. Например, часто можно встретить в ссылочном спаме анкер текста и спам-адрес веб-страницы.

В основе другого метода классификации способов спама лежит группа выражений в текстовых полях. Следовательно, у нас есть:

Бывает так, что спамеры повторяют большие куски текста (например, новости), которые размещены в Интернете, и в случайном порядке разбавляют их фразами со спамом. Такой метод продвижения дает результат, только если тема исходника насколько редкая, что лишь несколько веб-страниц ей релевантны. Накачивание большим количеством текста используют также для того, чтобы разбавлять текст, например, чтобы скрыть в нем повторяющиеся фразы со спамом и обмануть поисковые алгоритмы, фильтрующие явные повторы.

Это позволяет спамерам хорошо повышать релевантность веб-страницы к меньшему числу запросов.

В этом случае спамеры делают конкретную страницу релевантной многочисленным запросам. Хорошие результаты демпинг приносит в отношении редких и не совсем точных запросов. Последним явно будут соответствовать только 2-3 страницы. Поэтому даже та страница, где будет размещен низкорелевантный спам, войдет в ТОП-10 поисковой выдачи.

Еще один способ, который используют спамеры, чтобы быстро создавать контент.

Идея заключается в том, чтобы склеить предложения и фразы воедино, может быть даже из разных источников. Страница, напичканная спамом, впоследствии может появиться под любой запрос любой темы начального предложения.

Поисковики опираются не только на метрическую направленность, в основе которой лежат выражения. Также поисковые системы полагаются на ссылочные данные, определяя ценность страницы. В результате спамеры часто формируют ссылочную структуру, которая, как они планируют, повысит вес одной или нескольких страниц.

Как поисковики воюют с поисковым спамом: 3 способа выявления

Поисковые системы не любят поисковый спам и за обман, и главным образом за то, что он запутывает пользователя. В результате тот злится и переходит (может перейти) в другую поисковую систему, чтобы найти релевантные своему запросу данные. Поисковые системы борются за каждого пользователя, а потому стараются выдавать страницы только с качественным содержанием по запросам.

То есть активная борьба поисковых систем со спамом неизбежна. Поисковые системы пытаются его найти, исключить из базы и забанить веб-страницу или сайт, на котором он размещен.

Поисковый спам выявляется тремя способами:

Здесь поисковый спам находят, используя поисковые алгоритмы. С учетом характеристик того или иного вида спама алгоритмы ищут сайты, где используется нечестная оптимизация, и в дальнейшем снижают их позиции в выдаче.

Здесь поисковые алгоритмы ищут прежде всего подозрительные сайты и страницы. Окончательно решает, будет сайт забанен или его позиции снизятся, модератор (асессор) поисковика.

В этом случае модератор (асессор) самостоятельно проверяет, использует ли сайт поисковый спам. Основанием для таких проверок обычно служат жалобы от владельцев конкурирующих сайтов.

Как проверить заспамленность сайта

Для этого можно использовать несколько способов:

Алгоритмы, направленные на ссылочный спам

Спамер различает три типа интернет-страниц:

Принимая во внимание эту модель, расскажем о трех популярных алгоритмах, в основу которых положена ссылочная информация, используемая для оценки качества результатов.

Цель введения оригинального алгоритма HITS заключалась в ранжировании веб-страниц определенной тематической направленности. Но, как правило, алгоритм применяют ко всем интернет-страницам, чтобы найти ядро и понять, как результаты влияют на каждую страницу. В соответствии с циркулярным определением HITS главные весомые страницы — это те, что указывают на многие другие авторитетные веб-страницы, в то время как авторитетные страницы с большим весом — это те, на которые ссылаются основные. Поисковик, использующий алгоритм HITS-ранжирования страниц в качестве результата выдачи, выдает страницы с самым большим весом и авторитетом.

Завоевать хорошую репутацию сложнее, поскольку для этого на сайте должны присутствовать многочисленные входящие ссылки со страниц с предположительно большим весом. Спамер может сделать свою страницу более весомой (добавив на нее многочисленные исходящие ссылки), после чего сослаться с этих страниц на свою основную веб-страницу.

Благодаря ссылкам с доступных страниц, имеющих хороший авторитет, можно повысить репутацию главной страницы и таким образом продвинуть ее. Поэтому руководствоваться следует правилом «чем больше, тем лучше». Если бюджет спамера ограничен, ему нужно ссылаться со всех своих доступных веб-страниц к себе на главную. На собственных страницах, не являющихся главными, также стоит разместить ссылки на максимальное количество других (популярных) страниц с хорошей репутацией.

Результаты проведенного анализа алгоритма показали, что PageRank включает в себя r total-группу страниц (или, во всяком случае, одну страницу) и зависит от 4 параметров:

R total = r static + r in – r out – r sink,

где r static — вес, приобретенный из статического распределения (случайный скачок);

r in — вес, вытекающий из веб-страниц через входящие ссылки с внешних страниц;

r out — вес, утекающий с веб-страницы из-за исходящих ссылок на внешние страницы;

r sink — вес, утраченный из-за низких веб-страниц в группе (к примеру, страниц без исходящих ссылок).

Предыдущая формула ведет к качественной ссылочной структуре, повышающей вес главной страницы до предельного значения. У такой структуры оптимальные характеристики, она делает каждую свою страницу доступной с досягаемых веб-страниц (в связи с чем их может проиндексировать поисковая система), в ней минимум ссылок.

Для этой структуры применяют ряд приемов, позволяющих достичь максимального показателя авторитетности страницы фермы спама, особенно страницы t:

В ферме спама ссылочная структура по максимуму повышает вес страницы t при соблюдении следующих условий:

Технологии ссылочного спама

Добавляя исходящие ссылки на авторитетные веб-страницы вручную, вы можете увеличить основной вес. Но самый действенный способ — каталог ссылок. В интернете таких сайтов-каталогов достаточно много. Они распределяют контент по тематическим группам и подгруппам, подбирая соответствующие веб-ресурсы для каждой тематики по запросу. С помощью частичного и полного дублирования страниц каталога спамеры могут оперативно сформировать структуру исходящих ссылок.

Чтобы накопить достаточно много входящих ссылок на главную страницу или группу страниц, используются следующие способы:

Спамеры почти всегда пытаются скрыть указатели. Как правило, скрывают повторяющиеся фразы или большой перечень ссылок. Спамеры пользуются особыми методами, помогающими скрывать от людей и поисковых роботов свои очень заспамленные веб-страницы.

Какие бывают скрытые методы спама (с примерами)

Браузер при просмотре страницы может не видеть ключевые слова или ссылки, в которых есть поисковый спам. Очень часто контент скрывают, используя определенные цветовые схемы. Так, фразы в теле HTML-документа не видно, если их цвет совпадает с фоном страницы. Простой пример:

Таким методом поисковый спам можно скрыть, если избежать анкеров текста. Вместо этого спамеры часто формируют очень маленький, размером 1х1 pixel, рисунок анкера, также незаметный для посетителя, или такой же расцветки, как фон.

Кроме того, для сокрытия некоторых визуальных элементов на странице спамер может пользоваться скриптами, например поставить видимый атрибут стилей HTML на неправильный.

Веб-серверы, где есть поисковый спам, возвращают специальный HTML-документ стандартному веб-браузеру, в то время как пауку-роботу они возвращают совершенно иной документ. То есть спамеры могут предлагать умышленный контент пользователям (без каких-либо признаков спама на странице) и при этом направлять документ, в котором присутствует поисковый спам, поисковику для индексации.

Есть два способа распознавания поискового робота. Во-первых, некоторые спамеры сохраняют лист IP-адресов, которые используют поисковые системы, и определяют поисковые машины, сравнивая их с IP. Во-вторых, сервер может установить обращение, которое делает запрос документу на основе поля user-agent в тексте запроса HTTP. Допустим, следующее простое HTTP-сообщение о запросе имени user-agent — это имя, которое использует браузер Internet Explorer 6:

GET /db_pages/members.html HTTP/1.0

User-Agent: Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1)

Имена user-agent четко не нормированы, и вопрос поступающего обращения заключается в том, какую информацию нужно разместить в соответствующем текстовом поле. Однако поисковые роботы, как правило, самостоятельно идентифицируют себя по четкому названию, которое использует веб-браузер при обычных обращениях для предоставления правильной и вполне адекватной оптимизации. К примеру, некоторые сайты для поисковиков — это версии их веб-страниц без навигационных ссылок, рекламных сообщений и прочих визуальных элементов, относящихся к презентации, а не к содержанию. Такую деятельность поисковые системы приветствуют, поскольку она помогает индексировать полезный контент.

Для реализации переадресации есть несколько способов. Самый элементарный — применить метатег refresh в заголовке HTML-документа. При установлении времени обновления, равном 0, и обновлении адреса веб-страницы на главную спамеры могут достичь редиректа во время загрузки страницы браузером:

Поскольку предыдущий способ реализовать несложно, поисковики легко могут определить такие попытки редиректа с помощью синтаксического анализа метатегов. Более продвинутые спамеры делают редирект, используя некоторые скрипты на странице, поскольку роботы не исследуют скрипты:

Напоследок о том, как бороться с поисковым спамом

Мы рассказали о самых популярных способах борьбы с поисковым спамом. Распределение спама по группам позволяет вместе с тем классифицировать и методы противостояния этому явлению. Следовательно, стоит упомянуть о мерах борьбы со спамом, которыми могут пользоваться поисковики:

При этом проблему поискового спама можно рассматривать в целом, несмотря на то, что он делится на разные категории. В основе этого подхода лежит распознавание некоторых распространенных возможностей веб-страниц со спамом. Допустим, способы выявления спама подразумевают примерное изолирование известных веб-страниц без спама. На популярных страницах часто присутствуют ссылки на поисковый спам. То есть рациональный анализ ссылочного алгоритма можно использовать для отделения известных страниц от любого типа спама без учета его способов по отдельности.