Что такое поисковый робот

Роботы поисковой системы

Роботы поисковой системы, иногда их называют «пауки» или «кроулеры» (crawler) — это программные модули, занимающиеся поиском web-страниц. Как они работают? Что же они делают в действительности? Почему они важны?

Учитывая весь шум вокруг поисковой оптимизации и индексных баз данных поисковиков, вы, наверное думаете, что роботы должно быть великие и могущественные существа. Неправда. Роботы поисковика обладают лишь базовыми функциями, похожими на те, которыми обладали одни из первых броузеров, в отношении того, какую информацию они могут распознать на сайте. Как и ранние броузеры, роботы попросту не могут делать определенные вещи. Роботы не понимают фреймов, Flash анимаций, изображений или JavaScript. Они не могут зайти в разделы, защищенные паролем и не могут нажимать на все те кнопочки, которые есть на сайте. Они могут «заткнуться» в процессе индексирования динамических адресов URL и работать очень медленно, вплоть до остановки и безсилием над JavaScript-навигацией.

Как работают роботы поисковой машины?

Поисковые роботы стоит воспринимать, как программы автоматизированного получения данных, путешествующие по сети в поисках информации и ссылок на информацию.

Когда, зайдя на страницу «Submit a URL», вы регистрируете очередную web-страницу в поисковике — в очередь для просмотра сайтов роботом добавляется новый URL. Даже если вы не регистрируете страницу, множество роботов найдет ваш сайт, поскольку существуют ссылки из других сайтов, ссылающиеся на ваш. Вот одна из причин, почему важно строить ссылочную популярность и размещать ссылки на других тематических ресурсах.

Прийдя на ваш сайт, роботы сначала проверяют, есть ли файл robots.txt. Этот файл сообщает роботам, какие разделы вашего сайта не подлежат индексации. Обычно это могут быть директории, содержащие файлы, которыми робот не интересуется или ему не следовало бы знать.

Роботы хранят и собирают ссылки с каждой страницы, которую они посещают, а позже проходят по этим ссылкам на другие страницы. Вся всемирная сеть построена из ссылок. Начальная идея создания Интернет сети была в том, что бы была возможность перемещаться по ссылкам от одного места к другому. Вот так перемещаются и роботы.

«Остроумность» в отношении индексирования страниц в реальном режиме времени зависит от инженеров поисковых машин, которые изобрели методы, используемые для оценки информации, получаемой роботами поисковика. Будучи внедрена в базу данных поисковой машины, информация доступна пользователям, которые осуществляют поиск. Когда пользователь поисковой машины вводит поисковый запрос, производится ряд быстрых вычислений для уверенности в том, что выдается действительно правильный набор сайтов для наиболее релевантного ответа.

Вы можете просмотреть, какие страницы вашего сайта уже посетил поисковый робот, руководствуясь лог-файлами сервера, или результатами статистической обработки лог-файла. Идентифицируя роботов, вы увидите, когда они посетили ваш сайт, какие страницы и как часто. Некоторые роботы легко идентифицируются по своим именам, как Google’s «Googlebot». Другие более скрытые, как, например, Inktomi’s «Slurp». Другие роботы так же могут встречаться в логах и не исключено, что вы не сможете сразу их идентифицировать; некоторые из них могут даже оказаться броузерами, которыми управляют люди.

Помимо идентификации уникальных поисковых роботов и подсчета количества их визитов, статистика также может показать вам агрессивных, поглощающих ширину катала пропускания роботов или роботов, нежелательных для посещения вашего сайта.

Как они читают страницы вашего web-сайта?

Когда поисковой робот посещает страницу, он просматривает ее видимый текст, содержание различных тегов в исходном коде вашей страницы (title tag, meta tags, и т.д.), а так же гиперссылки на странице. Судя по словам ссылок, поисковая машина решает, о чем страница. Есть много факторов, используемых для вычисления ключевых моментов страницы «играющих роль». Каждая поисковая машина имеет свой собственный алгоритм для оценки и обработки информации. В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базу данных поисковой системы.

После этого, информация, доставленная в индексные базы данных поисковой системы, становится частью поисковика и процесса ранжирования в базе. Когда посетитель существляет запрос, поисковик просматривает всю базу данных для выдачи конечного списка, релевантного поисковому запросу.

Базы данных поисковых систем подвергаются тщательной обработке и приведению в соответствие. Если вы уже попали в базу данных, роботы будут навещать вас периодически для сбора любых изменений на страницах и уверенности в том, что обладают самой последней информацией. Количество посещений зависит от установок поисковой машины, которые могут варьироваться от ее вида и назначения.

Иногда поисковые роботы не в состоянии проиндексировать web-сайт. Если ваш сайт упал или на сайт идет большое количество посетителей, робот может быть безсилен в попытках его индексации. Когда такое происходит, сайт не может быть переиндексирован, что зависит от частоты его посещения роботом. В большинстве случаев, роботы, которые не смогли достичь ваших страниц, попытаются позже, в надежде на то, что ваш сайт в ближайшее время будет доступен.

Многие поисковые роботы не могут быть идентифицированы, когда вы просматриваете логи. Они могут посещать вас, но логи утверждают, что кто-то использует Microsoft броузер и т.д. Некоторые роботы идентифицируют себя использованием имени поисковика (googlebot) или его клона (Scooter = AltaVista).

В зависимости от того, как робот настроен, информация индексируется, а затем доставляется в базы данных поисковой машины.

Базы данных поисковых машин подвергаются модификации в различные сроки. Даже директории, имеющие вторичные поисковые результаты используют данные роботов как содержание своего web-сайта.

Собственно, роботы не используются поисковиками лишь для вышеизложенного. Существуют роботы, которые проверяют баз данных на наличие нового содержания, навещают старое содержимое базы, проверяют, не изменились ли ссылки, загружают целые сайты для просмотра и так далее.

По этой причине, чтение лог-файлов и слежение за выдачей поисковой системы помогает вам наблюдать за индексацией ваших проектов.

Что такое поисковый робот и как он работает

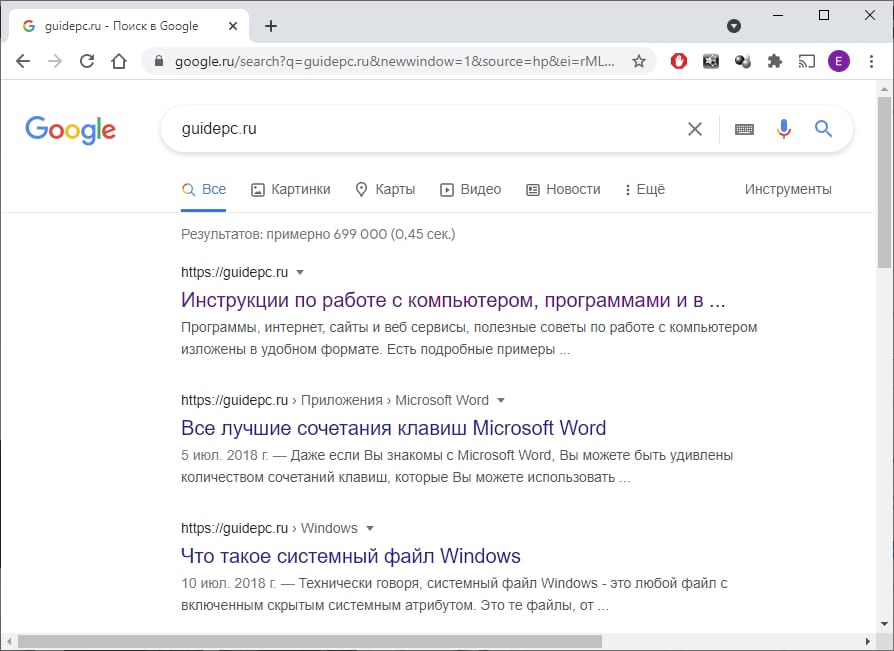

В ы когда-нибудь искали что-то в Google и задавались вопросом: «Как он узнает, где искать?» Ответ — «поисковые роботы», которые индексируют сайты, чтобы Вы могли легко находить нужные вещи в Интернете.

Поисковые системы и поисковые роботы

Когда Вы выполняете поиск по ключевому слову в такой поисковой системе, как Google или Яндекс, сайт просматривает триллионы страниц, чтобы сформировать список результатов, связанных с этим термином. Как именно эти поисковые системы хранят все эти страницы в файлах, знают, как их искать, и генерируют эти результаты в считанные секунды?

Ответ — поисковые роботы. Это автоматизированные программы (часто называемые «роботами» или «ботами»), которые «сканируют» или просматривают веб-страницы, чтобы их можно было добавить в поисковые системы. Эти роботы индексируют веб-сайты, чтобы создать список страниц, которые в конечном итоге появятся в Ваших результатах поиска.

Поисковые роботы также создают и хранят копии этих страниц в базе данных движка, что позволяет выполнять поиск практически мгновенно. Это также причина, по которой поисковые системы часто включают кешированные версии сайтов в свои базы данных.

Карты сайта и выбор

Итак, как сканеры выбирают, какие веб-сайты сканировать? Наиболее распространенный сценарий заключается в том, что владельцы веб-сайтов хотят, чтобы поисковые системы сканировали их сайты. Они могут добиться этого, попросив Google, Яндекс, Bing, Yahoo или другую поисковую систему проиндексировать свои страницы. Этот процесс варьируется от движка к движку. Кроме того, поисковые системы часто выбирают для сканирования популярные веб-сайты с хорошими ссылками, отслеживая, сколько раз URL ссылается на другие общедоступные сайты.

Владельцы веб-сайтов могут использовать определенные процессы, чтобы помочь поисковым системам индексировать свои веб-сайты, например, загрузка карты сайта. Это файл, содержащий все ссылки и страницы, которые являются частью Вашего веб-сайта. Обычно он используется, чтобы указать, какие страницы Вы хотите проиндексировать.

После того, как поисковые системы уже просканировали сайт один раз, они автоматически просканируют этот сайт снова. Частота варьируется в зависимости от того, насколько популярен веб-сайт, среди других показателей. Поэтому владельцы сайтов часто обновляют карты сайтов, чтобы системы знали, какие новые страницы нужно проиндексировать.

robots.txt

Что делать, если веб-сайт не хочет, чтобы некоторые или все его страницы отображались в поисковой системе? Например, Вы можете не захотеть, чтобы люди искали страницу только для вошедших пользователей или видели Вашу страницу с ошибкой 404. Здесь вступает в силу список исключений сканирования, также известный как robots.txt. Это простой текстовый файл, который указывает сканерам, какие веб-страницы исключить из индексации.

Еще одна причина важности файла robots.txt заключается в том, что поисковые роботы могут существенно повлиять на производительность сайта. Поскольку сканеры, по сути, загружают все страницы Вашего веб-сайта, они потребляют ресурсы и могут замедлять работу. Они приходят в непредсказуемое время и без одобрения. Если Вам не нужно повторно индексировать страницы, остановка поисковых роботов может помочь снизить нагрузку на Ваш сайт. К счастью, большинство поисковых роботов прекращают сканирование определенных страниц в соответствии с правилами владельца сайта.

Магия метаданных

Под URL-адресом и заголовком каждого результата поиска в Google Вы найдете краткое описание страницы. Эти описания называются фрагментами. Вы можете заметить, что фрагмент страницы в Google не всегда совпадает с фактическим содержанием веб-сайта. Это связано с тем, что на многих веб-сайтах есть так называемые «метатеги», которые представляют собой настраиваемые описания, которые владельцы сайтов добавляют на свои страницы.

Владельцы сайтов часто придумывают заманчивые описания метаданных, написанные для того, чтобы Вы захотели перейти на сайт. Google также показывает другую метаинформацию, такую как цены и наличие на складе. Это особенно полезно для тех, у кого есть сайты электронной коммерции.

Ваш поиск

Веб-поиск — важная часть использования Интернета. Поиск в Интернете — отличный способ обнаружить новые веб-сайты, магазины, сообщества и интересы. Каждый день поисковые роботы посещают миллионы страниц и добавляют их в поисковые системы. Хотя поисковые роботы имеют некоторые недостатки, например, занимают ресурсы сайта, они неоценимы как для владельцев сайтов, так и для посетителей.

Термин: Поисковый робот

Поисковый робот — специальная программа, принадлежащая определенной поисковой системе и предназначенная для индексирования (занесения в базу сайтов поисковой системы) веб-сайтов и их страниц, найденных в интернет-пространстве. Также принятые названия: краулер, бот, паук, webcrawler, bot, automaticindexer, ant, webrobots, webspider, webscutter.

Принцип работы

Поисковый робот является браузерного типа программой. Он постоянно сканирует веб-пространство, посещая уже известные ему (проиндексированные) сайты, проходя по ссылкам с них и находя, таким образом, новые ресурсы. Обнаружив неизвестный сайт, и проведя некоторые процедуры, робот добавляет его в индекс поисковой системы.

Кроме того, поисковым роботом индексируются обновления на сайтах. Причем, периодичность обновлений фиксируется. К примеру, сайт, обновляемый раз в неделю, будет посещаться роботом с той же частотой, а информация на новостных сайтах может индексироваться уже через несколько минут.

Сайтам, не обладающим внешней ссылочной массой, то есть тем из них, на которые не ведут ссылки с других ресурсов, чтобы быть проиндексированными, необходимо привлечь внимание поисковых роботов. Для этого сайт добавляется в специальную форму поисковой системы. К примеру, в панель вебмастера Яндекс, или в Центр вебмастеров Google.

Виды поисковых роботов

На самом деле понятием «поисковый робот» объединена их некоторая совокупность. Каждая поисковая система улучшает процесс сканирования веб-пространства и индексацию, используя несколько роботов, наделенных более узкой специализацией. К примеру, Яндекс сегодня использует следующие, действующие одновременно боты:

Управление индексацией

Несмотря на то, что чтобы быть замеченным, сайт должен оказаться проиндексированным, далеко не всегда требуется, чтобы вся информация с него была доступна пользователям и, соответственно, поисковому роботу. К примеру, интернет-магазины закрывают от индексации страницы с реквизитами покупателей, значительная часть сайтов — административные данные и т.п.

Закрыть от индексации поисковыми роботами все содержимое сайта или только часть информации, размещенной на нем, можно с помощью файла robots.txt. В нем, согласно определенным правилам, с помощью специальных директив в текстовом формате прописываются указания для поисковых роботов. Надо заметить, что роботы, попадая на сайт, ищут в первую очередь файл robots.txt. Знакомятся с инструкциями (если файл существует) и в соответствии с ними индексируют страницы.

Директивы файла robots.txt:

Виды поисковых роботов

Поисковый робот или паук — это специальная программа, предназначенная для сканирования сайтов. Робот, переходя по ссылкам, индексирует информацию и сохраняет ее в базе поисковых систем.

Существует множество видов различных поисковых роботов, каждый из которых выполняет определенную функцию.

Подробнее узнать о поисковых роботах Google можно в официальной справке компании.

Подробнее о поисковых роботах Яндекса можно в официальной справке компании.

При помощи файла robots.txt или мета-тега можно запретить поисковым роботам индексацию определенных страниц. Для этого нужно добавить соответствующие правила, и указать к какому роботу они относятся в директиве User-agent файла robots.txt или атрибуте name мета-тега.

Например, нижеприведенный код в файле robots.txt запрещает роботу Яндекс.Картинок индексировать все изображения.

А этот запрещает главному поисковому роботу Google индексировать страницу, на которой размещен данный тег:

О том, как правильно настроить индексирование сайта, можно узнать в статье.

Ждите новые заметки в блоге или ищите на нашем сайте.

Добавил в закладки, очень полезный материал. Часто бывает нужно указать бота, и приходится лезть в документацию поисковиков.

На прошедшем Go meetup спикеры из Evrone, «Ситимобил» и «Авито» учили правильной организации кода микросервиса, рассказывали, как вырастить MVP в полноценную масштабируемую архитектуру, и разобраться с мусором и алгоритмами управления памятью. Все доклады записаны в студии и доступны для просмотра.

Что такое поисковый робот, и как он работает

Поделиться этим постом

Чтобы знать и понимать принципы сканирования и индексации, стоит ознакомиться с особенностями работы поисковых роботов. Они принимают непосредственное участие в этих процессах, собирают и обновляют всю информацию о страницах сайта. Подробнее о том, что такое поисковый робот, и как он работает, поговорим в этом посте.

1. Что такое поисковый робот

Поисковый робот — это программа для сканирования и индексации сайтов. Он позволяет поисковой системе получить сведения о веб-страницах и внести их в базу для последующей выдачи пользователям при запросе. Боты не анализируют собранные данные, а только передают их на сервера поисковых систем. Для эффективной индексации сайта необходимо учитывать особенности обработки веб-страниц ботами.

Поисковых роботов называют по-разному: краулеры, боты, веб-пауки. Во всех этих случаях речь идёт об одинаковых программах. Они заходят на сайт, заносят содержимое в индекс и находят ссылки, по которым переходят на другие страницы. Для ускорения индексации создаются файлы robots.txt и XML Sitemap.

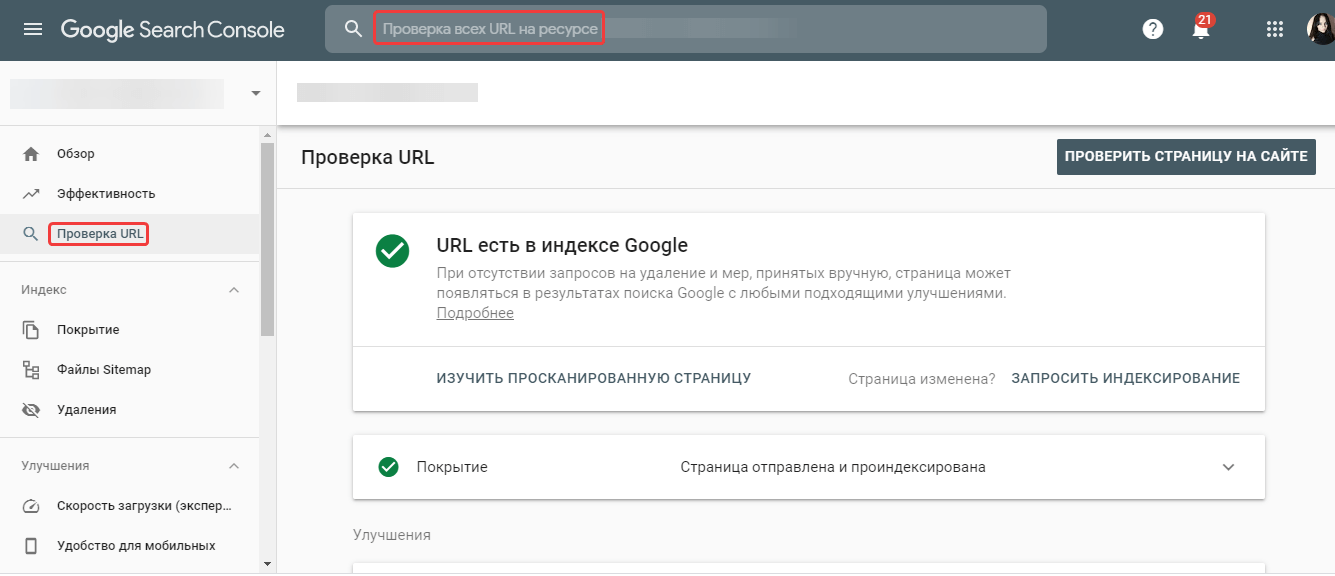

Чтобы узнать, есть ли URL в индексе Google, выполните проверку в сервисе Google Search Console.

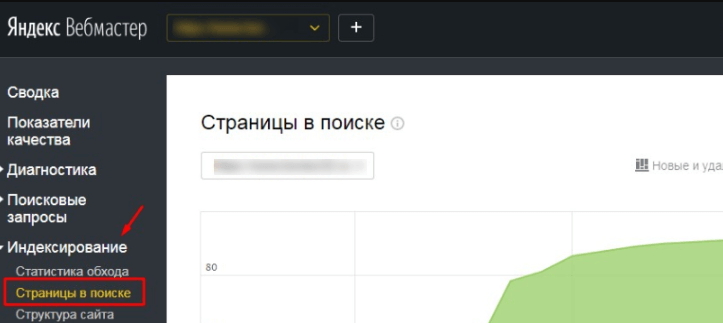

Для проверки страниц в индексе Яндекс, откройте отчёт «Страницы в поиске» в Яндекс.Вебмастер.

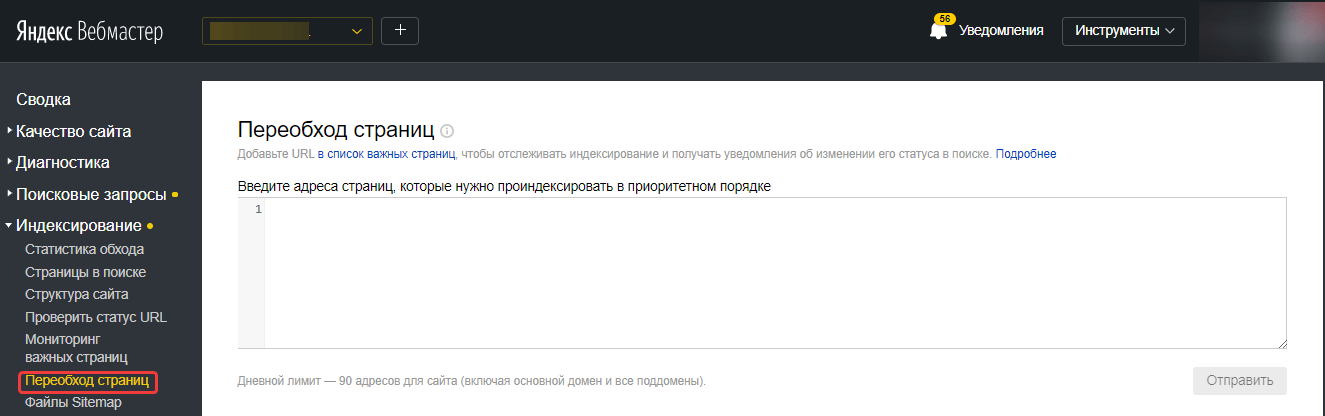

Также в сервисе можно запросить переобход URL в панели Яндекс.Вебмастера в разделе «Переобход новых страниц». С помощью данного инструмента можно добавить до 90 новых страниц в день.

2. Принцип работы поисковых роботов и их функции

Поисковая выдача формируется в три этапа:

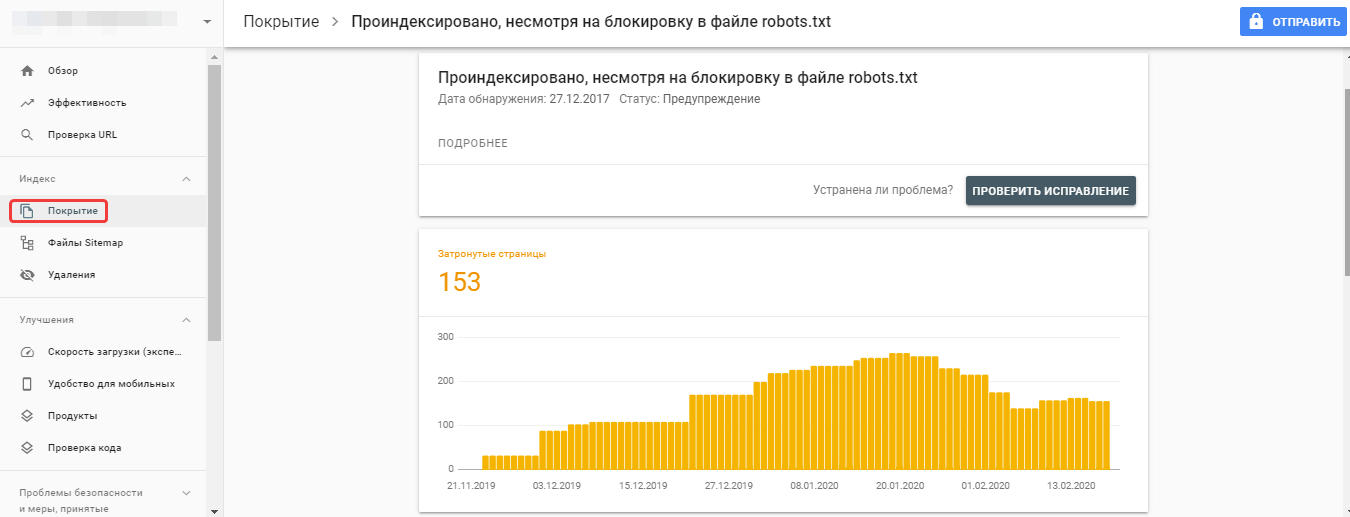

Иногда процесс индексации страниц происходит даже без их предварительного сканирования. В файле robots.txt указываются правила для сканирования, но не индексирования страниц. Поэтому если поисковый робот обнаружит страницу другим способом, например, если на неё ссылаются сторонние ресурсы, то может добавить её в базу.

В данном случае необходимо убрать запрет на сканирование этих служебных страниц из файла robots.txt, используя только запрет индексации на страницах:

2.1. Рекомендации роботам по доступу к контенту сайта

Рекомендации по индексации материалов на сайте можно задавать с помощью файлов sitemap.xml и robots.txt:

В robots.txt для запрета индексации используется директива Disallow. Например, чтобы полностью запретить доступ всех ботов к сайту, прописываются такие строчки кода:

При добавлении директив их порядок не принципиален, после данной команды можно открыть какой-либо раздел сайта для индексации при помощи директивы Allow.

3. Особенности работы с поисковыми ботами

Чтобы индексация сайта поисковыми роботами происходила быстро и эффективно, необходимо:

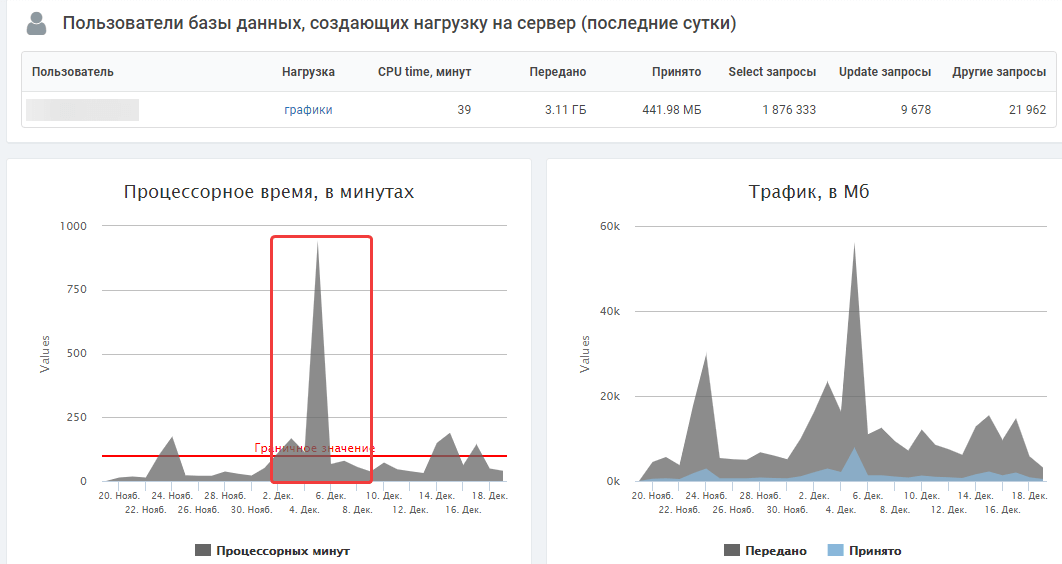

3.1. Высокая нагрузка на сервер при посещениях роботов

Индексация ботами поисковых систем крайне важна для продвижения, однако в некоторых ситуациях она может перегружать сервер, либо под видом роботов сайт могут атаковать хакеры. Чтобы знать цели, с которыми боты обращаются к ресурсу, и отслеживать возможные проблемы, проверяйте логи сервера и динамику серверной нагрузки в панели хостинг-провайдера. Критические значения могут свидетельствовать о проблемах, связанных с активным доступом к сайту поисковых роботов.

Когда роботы перегружают сервер слишком активными запросами к сайту, можно снизить их скорость обхода. Как это сделать, узнайте из справок Яндекс и Google.

3.2. Проблемы из-за доступа фейковых ботов к сайту

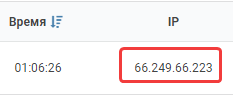

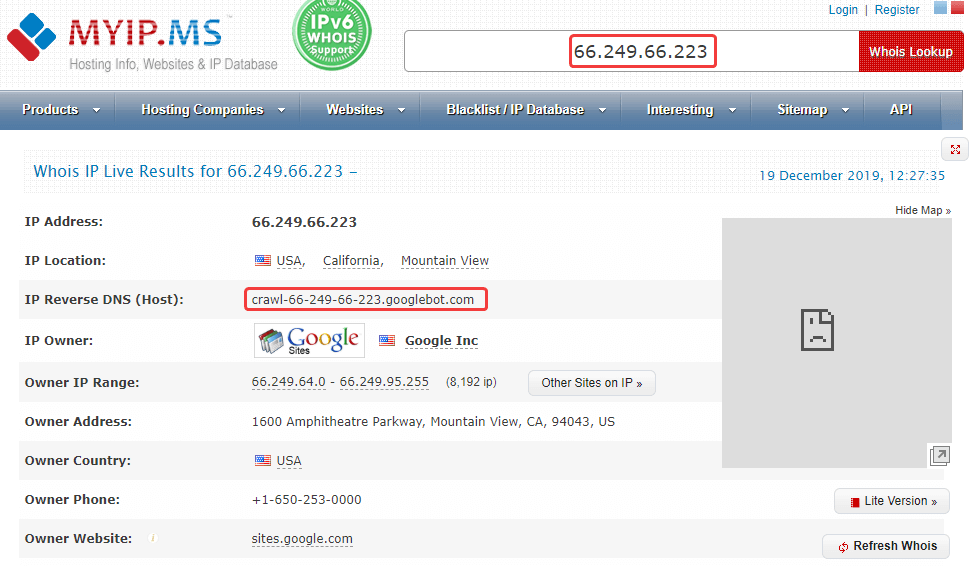

Бывает, что под видом ботов Google к сайту пытаются получить доступ спамеры или хакеры. Если возникла такая проблема, проверьте, действительно ли сайт сканирует поисковый робот Google:

Полученный IP-адрес должен совпадать с исходным в логах сервера, иначе это говорит о том, что имя бота поддельное. В данном случае сайт действительно сканировал Googlebot Аналогично проверяются и вызвавшие подозрения боты Яндекса.

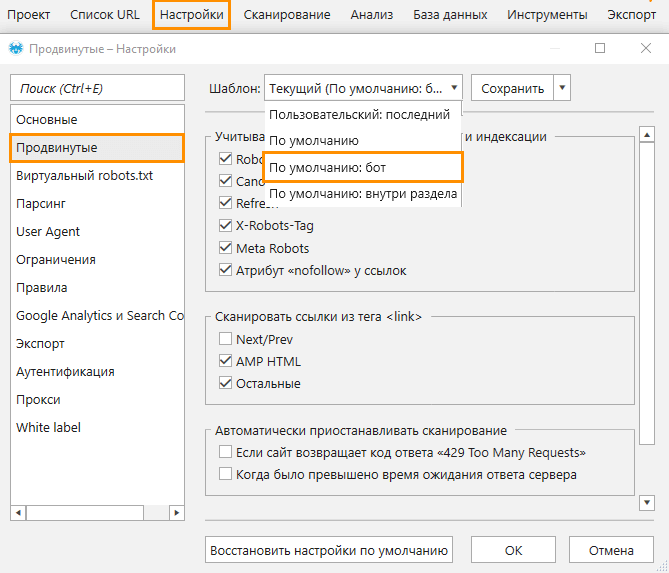

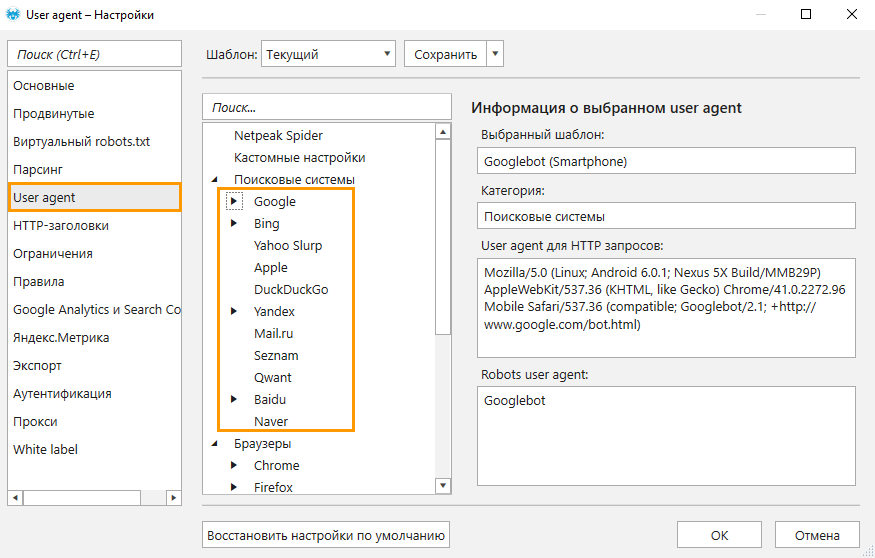

Чтобы узнать, как тот или иной поисковый бот сканирует ваш сайт, воспользуйтесь краулером Netpeak Spider, который позволяет имитировать поведение робота. Для анализа необходимо:

Проверять, как сайт отвечает на запросы от разных User agent, вы можете в бесплатной версии Netpeak Spider без ограничений по времени! Во Freemium-версии также доступны и многие другие базовые функции программы.

Чтобы начать пользоваться бесплатным Netpeak Spider, просто зарегистрируйтесь, скачайте и установите программу — и вперёд! 😉

P.S. Сразу после регистрации у вас также будет возможность потестировать весь платный функционал, а затем сравнить все наши тарифы и выбрать для себя подходящий.

3.3. Список ботов поисковых систем

Поисковые системы используют различные типы роботов: для индексации обычных страниц, новостей, изображений, фавиконов и прочих типов контента. Список IP-адресов, которые используют боты поисковиков, постоянно меняется и не разглашается.

3.2.1. Роботы Google

Полный список роботов Google можно посмотреть в справке. Рассмотрим наиболее популярных ботов:

3.2.2. Роботы Яндекс

У Яндекса тоже обширный список ботов, который можно детально изучить в Яндекс.Помощи. Расскажу о некоторых из них:

Подводим итоги

Благодаря поисковым роботам происходит сканирование и индексация ресурсов. Робот сам находит новые веб-страницы, но чтобы ускорить индексацию, можно сообщить о появлении новых URL вручную посредством инструментов поисковых систем (Google Search Console, Яндекс.Метрика). Для управления индексацией материалов можно задать указания ботам при помощи файлов XML Sitemap и robots.txt.

А как вы «общаетесь» с ботами поисковых систем? Делитесь в комментариях.