Что такое энтропия простым языком

Энтропия? Это просто!

Этот пост является вольным переводом ответа, который Mark Eichenlaub дал на вопрос What’s an intuitive way to understand entropy?, заданный на сайте Quora

Энтропия. Пожалуй, это одно из самых сложных для понимания понятий, с которым вы можете встретиться в курсе физики, по крайней мере если говорить о физике классической. Мало кто из выпускников физических факультетов может объяснить, что это такое. Большинство проблем с пониманием энтропии, однако, можно снять, если понять одну вещь. Энтропия качественно отличается от других термодинамических величин: таких как давление, объём или внутренняя энергия, потому что является свойством не системы, а того, как мы эту систему рассматриваем. К сожалению в курсе термодинамики её обычно рассматривают наравне с другими термодинамическими функциями, что усугубляет непонимание.

Так что же такое энтропия?

Энтропия — это то, как много информации вам не известно о системе

Например, если вы спросите меня, где я живу, и я отвечу: в России, то моя энтропия для вас будет высока, всё-таки Россия большая страна. Если же я назову вам свой почтовый индекс: 603081, то моя энтропия для вас понизится, поскольку вы получите больше информации.

Почтовый индекс содержит шесть цифр, то есть я дал вам шесть символов информации. Энтропия вашего знания обо мне понизилась приблизительно на 6 символов. (На самом деле, не совсем, потому что некоторые индексы отвечают большему количеству адресов, а некоторые — меньшему, но мы этим пренебрежём).

Или рассмотрим другой пример. Пусть у меня есть десять игральных костей (шестигранных), и выбросив их, я вам сообщаю, что их сумма равна 30. Зная только это, вы не можете сказать, какие конкретно цифры на каждой из костей — вам не хватает информации. Эти конкретные цифры на костях в статистической физике называют микросостояниями, а общую сумму (30 в нашем случае) — макросостоянием. Существует 2 930 455 микросостояний, которые отвечают сумме равной 30. Так что энтропия этого макросостояния равна приблизительно 6,5 символам (половинка появляется из-за того, что при нумерации микросостояний по порядку в седьмом разряде вам доступны не все цифры, а только 0, 1 и 2).

А что если бы я вам сказал, что сумма равна 59? Для этого макросостояния существует всего 10 возможных микросостояний, так что его энтропия равна всего лишь одному символу. Как видите, разные макросостояния имеют разные энтропии.

Пусть теперь я вам скажу, что сумма первых пяти костей 13, а сумма остальных пяти — 17, так что общая сумма снова 30. У вас, однако, в этом случае имеется больше информации, поэтому энтропия системы для вас должна упасть. И, действительно, 13 на пяти костях можно получить 420-ю разными способами, а 17 — 780-ю, то есть полное число микросостояний составит всего лишь 420х780 = 327 600. Энтропия такой системы приблизительно на один символ меньше, чем в первом примере.

Мы измеряем энтропию как количество символов, необходимых для записи числа микросостояний. Математически это количество определяется как логарифм, поэтому обозначив энтропию символом S, а число микросостояний символом Ω, мы можем записать:

Это есть ничто иное как формула Больцмана (с точностью до множителя k, который зависит от выбранных единиц измерения) для энтропии. Если макросостоянию отвечают одно микросостояние, его энтропия по этой формуле равна нулю. Если у вас есть две системы, то полная энтропия равна сумме энтропий каждой из этих систем, потому что log(AB) = log A + log B.

Из приведённого выше описания становится понятно, почему не следует думать об энтропии как о собственном свойстве системы. У системы есть опеделённые внутренняя энергия, импульс, заряд, но у неё нет определённой энтропии: энтропия десяти костей зависит от того, известна вам только их полная сумма, или также и частные суммы пятёрок костей.

Другими словами, энтропия — это то, как мы описываем систему. И это делает её сильно отличной от других величин, с которыми принято работать в физике.

Физический пример: газ под поршнем

Классической системой, которую рассматривают в физике, является газ, находящийся в сосуде под поршнем. Микросостояние газа — это положение и импульс (скорость) каждой его молекулы. Это эквивалентно тому, что вы знаете значение, выпавшее на каждой кости в рассмотренном раньше примере. Макросостояние газа описывается такими величинами как давление, плотность, объём, химический состав. Это как сумма значений, выпавших на костях.

Величины, описывающие макросостояние, могут быть связаны друг с другом через так называемое «уравнение состояния». Именно наличие этой связи позволяет, не зная микросостояний, предсказывать, что будет с нашей системой, если начать её нагревать или перемещать поршень. Для идеального газа уравнение состояния имеет простой вид:

Величины типа давления, температуры и плотности называются усреднёнными, поскольку являются усреднённым проявлением постоянно сменяющих друг друга микросостояний, отвечающих данному макросостоянию (или, вернее, близким к нему макросостояниям). Чтобы узнать в каком микросостоянии находится система, нам надо очень много информации — мы должны знать положение и скорость каждой частицы. Количество этой информации и называется энтропией.

Как меняется энтропия с изменением макросостояния? Это легко понять. Например, если мы немного нагреем газ, то скорость его частиц возрастёт, следовательно, возрастёт и степень нашего незнания об этой скорости, то есть энтропия вырастет. Или, если мы увеличим объём газа, отведя поршень, увеличится степень нашего незнания положения частиц, и энтропия также вырастет.

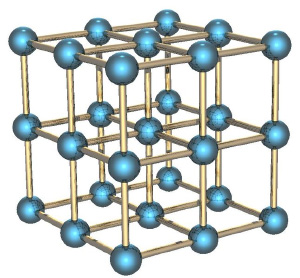

Твёрдые тела и потенциальная энергия

Если мы рассмотрим вместо газа какое-нибудь твёрдое тело, особенно с упорядоченной структурой, как в кристаллах, например, кусок металла, то его энтропия будет невелика. Почему? Потому что зная положение одного атома в такой структуре, вы знаете и положение всех остальных (они же выстроены в правильную кристаллическую структуру), скорости же атомов невелики, потому что они не могут улететь далеко от своего положения и лишь немного колеблются вокруг положения равновесия.

Если кусок металла находится в поле тяготения (например, поднят над поверхностью Земли), то потенциальная энергия каждого атома в металле приблизительно равна потенциальной энергии других атомов, и связанная с этой энергией энтропия низка. Это отличает потенциальную энергию от кинетической, которая для теплового движения может сильно меняться от атома к атому.

Если кусок металла, поднятый на некоторую высоту, отпустить, то его потенциальная энергия будет переходить в кинетическую энергию, но энтропия возрастать практически не будет, потому что все атомы будут двигаться приблизительно одинаково. Но когда кусок упадёт на землю, во время удара атомы металла получат случайное направление движения, и энтропия резко увеличится. Кинетическая энергия направленного движения перейдёт в кинетическую энергию теплового движения. Перед ударом мы приблизительно знали, как движется каждый атом, теперь мы эту информацию потеряли.

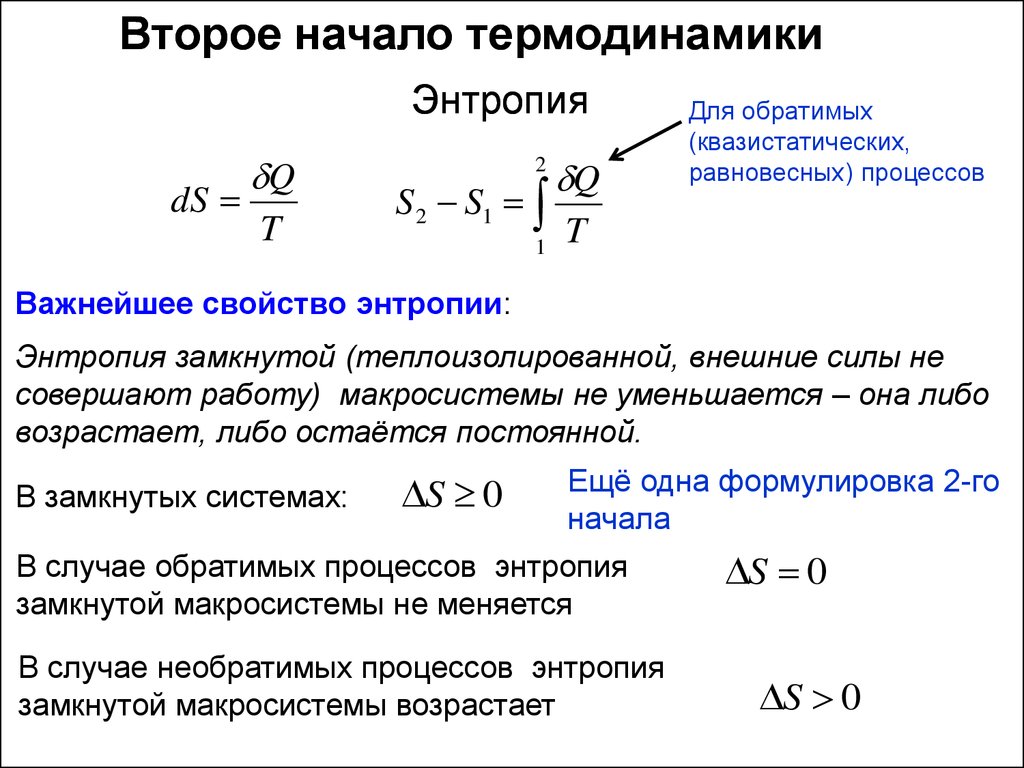

Понимаем второй закон термодинамики

Второй закон термодинамики утверждает, что энтропия (замкнутой системы) никогда не уменьшается. Мы теперь можем понять, почему: потому что невозможно внезапно получить больше информации о микросостояниях. Как только вы потеряли некую информацию о микросостоянии (как во время удара куска металла об землю), вы не можете вернуть её назад.

Давайте вернёмся обратно к игральным костям. Вспомним, что макросостояние с суммой 59 имеет очень низкую энтропию, но и получить его не так-то просто. Если бросать кости раз за разом, то будут выпадать те суммы (макросостояния), которым отвечает большее количество микросостояний, то есть будут реализовываться макросостояния с большой энтропией. Самой большой энтропией обладает сумма 35, и именно она и будет выпадать чаще других. Именно об этом и говорит второй закон термодинамики. Любое случайное (неконтролируемое) взаимодействие приводит к росту энтропии, по крайней мере до тех пор, пока она не достигнет своего максимума.

Перемешивание газов

И ещё один пример, чтобы закрепить сказанное. Пусть у нас имеется контейнер, в котором находятся два газа, разделённых расположенной посередине контейнера перегородкой. Назовём молекулы одного газа синими, а другого — красными.

Если открыть перегородку, газы начнут перемешиваться, потому что число микросостояний, в которых газы перемешаны, намного больше, чем микросостояний, в которых они разделены, и все микросостояния, естественно, равновероятны. Когда мы открыли перегородку, для каждой молекулы мы потеряли информацию о том, с какой стороны перегородки она теперь находится. Если молекул было N, то утеряно N бит информации (биты и символы, в данном контексте, это, фактически, одно и тоже, и отличаются только неким постоянным множителем).

Разбираемся с демоном Максвелла

Ну и напоследок рассмотрим решение в рамках нашей парадигмы знаменитого парадокса демона Максвелла. Напомню, что он заключается в следующем. Пусть у нас есть перемешанные газы из синих и красных молекул. Поставим обратно перегородку, проделав в ней небольшое отверстие, в которое посадим воображаемого демона. Его задача — пропускать слева направо только красных, и справа налево только синих. Очевидно, что через некоторое время газы снова будут разделены: все синие молекулы окажутся слева от перегородки, а все красные — справа.

Получается, что наш демон понизил энтропию системы. С демоном ничего не случилось, то есть его энтропия не изменилась, а система у нас была закрытой. Получается, что мы нашли пример, когда второй закон термодинамики не выполняется! Как такое оказалось возможно?

Решается этот парадокс, однако, очень просто. Ведь энтропия — это свойство не системы, а нашего знания об этой системе. Мы с вами знаем о системе мало, поэтому нам и кажется, что её энтропия уменьшается. Но наш демон знает о системе очень много — чтобы разделять молекулы, он должен знать положение и скорость каждой из них (по крайней мере на подлёте к нему). Если он знает о молекулах всё, то с его точки зрения энтропия системы, фактически, равна нулю — у него просто нет недостающей информации о ней. В этом случае энтропия системы как была равна нулю, так и осталась равной нулю, и второй закон термодинамики нигде не нарушился.

Но даже если демон не знает всей информации о микросостоянии системы, ему, как минимум, надо знать цвет подлетающей к нему молекулы, чтобы понять, пропускать её или нет. И если общее число молекул равно N, то демон должен обладать N бит информации о системе — но именно столько информации мы и потеряли, когда открыли перегородку. То есть количество потерянной информации в точности равно количеству информации, которую необходимо получить о системе, чтобы вернуть её в исходное состояние — и это звучит вполне логично, и опять же не противоречит второму закону термодинамики.

Все меняется, и некоторым из нас это не всегда нравится. Но согласно одной из точек зрения, энтропия Вселенной и природы в целом (то есть степень беспорядка или случайности в системе) может быть тем, что в первую очередь способствовало возникновению жизни.

реклама

Согласно этой точке зрения, когда группа атомов приводится в движение внешним источником энергии, например Солнцем, и окружена источником тепла, например атмосферой, она постепенно перестраивается таким образом, чтобы рассеивать все больше энергии. С этого момента, при определенных условиях, материя неумолимо приобретает свойства, ассоциирующиеся с жизнью.

Однако энтропию также связывают с тепловой смертью Вселенной. Вот все, что необходимо знать об энтропии в термодинамике и о том, как она влияет на Вселенную и, в конечном счете, на нас.

Что такое энтропия Вселенной?

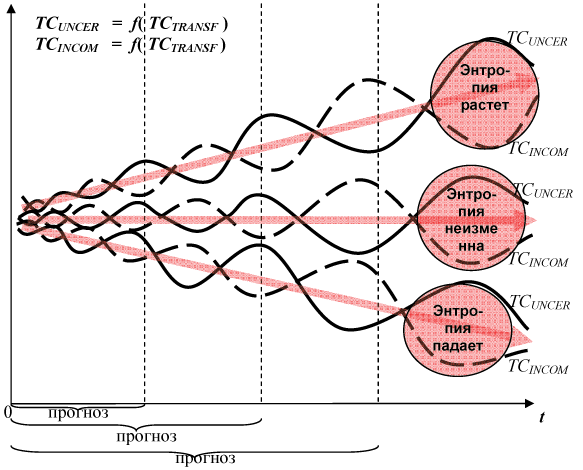

Хотя в физике это не одно и то же, полезно вспомнить о теории хаоса и о том, как она связана с энтропией, и, в конечном счете, какое влияние энтропия может оказывать на Вселенную.

реклама

Согласно теории хаоса, в кажущейся случайности хаотических, сложных систем есть скрытые закономерности и взаимосвязи. Если знать начальные условия и выяснить эти базовые закономерности, то можно предсказать нарушения, которые произойдут в будущем. Другими словами, хаос не так беспорядочен и случаен, как может показаться.

В своей самой простой формулировке энтропия определяется как мера тепловой энергии в системе на единицу температуры, которая не может быть использована для совершения полезной работы. Поскольку работа получается в результате упорядоченного движения молекул, энтропия также является мерой молекулярного беспорядка, или случайности, в системе.

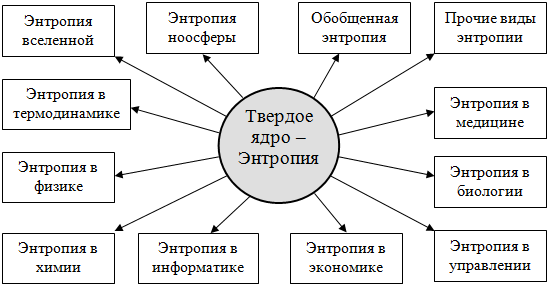

Не только физика, но и многие дисциплины нашли применение этой концепции, включая химию, биологию, изменение климата, социологию, экономику, теорию информации и даже бизнес.

Но давайте остановимся на физике, а точнее, на фундаментальных законах термодинамики.

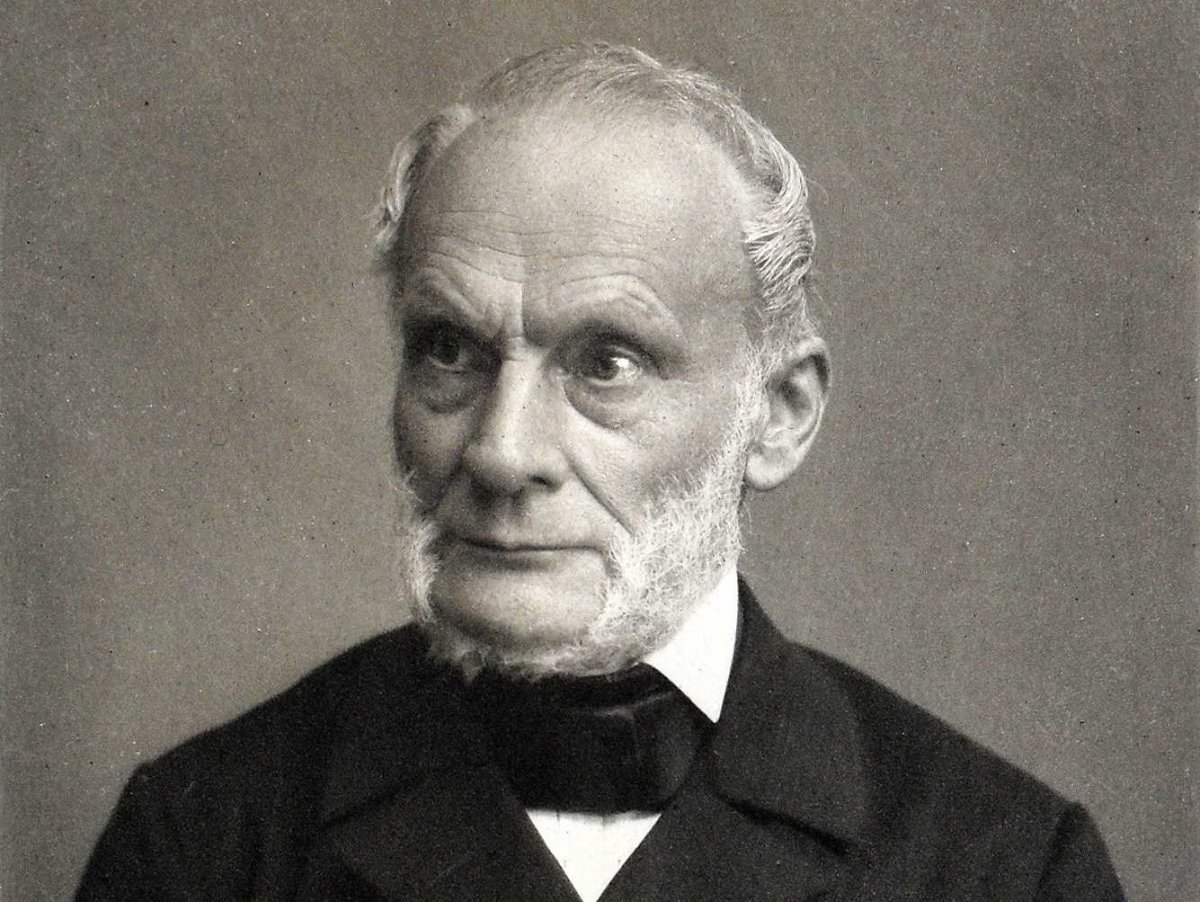

Кто ввел понятие энтропии?

реклама

Несмотря на то, что понятие энтропии применяется в различных дисциплинах, оно берет свое начало в физике. Изучая сохранение механической энергии в своей работе » Основные принципы равновесия и движения» (1803), французский математик Лазар Карно предложил, что ускорения и удары движущихся частей в машине представляют собой «потери момента активности». Момент активности» Карно сопоставим с современным понятием работы в термодинамике. Таким образом, в любом естественном процессе существует неотъемлемая тенденция к рассеиванию полезной энергии.

Другие ученые исследовали эту «потерянную» энергию, и в последней половине 19 века они указали, что это не настоящее исчезновение, а преобразование. Это и есть концепция сохранения энергии, которая проложила путь к первому закону термодинамики. Такие ученые, как Джеймс Джоуль, Юлиус Майер, Герман Гельмгольц и Уильям Томпсон (также известный как лорд Кельвин), опубликовали работы, исследующие эту концепцию.

реклама

Но термин «энтропия» появился в работах немецкого физика Рудольфа Клаузиуса, который сегодня считается одним из авторов термодинамики.

В 1850-х годах он представил изложение Второго закона термодинамики применительно к тепловому насосу. Заявление Клаузиуса подчеркивало тот факт, что невозможно построить устройство, работающее по циклу и не производящее никакого другого эффекта, кроме передачи тепла от более холодного тела к более горячему.

В 1860-х годах он придумал слово «энтропия» от греческого слова, означающего превращение, или поворотный пункт, для обозначения необратимой потери тепла. Он описал ее как функцию состояния в термодинамическом цикле, в частности в цикле Карно, теоретическом цикле, предложенном сыном Лазаря Карно, Сади Карно.

В 1870-х годах австрийский физик и философ Людвиг Больцман переосмыслил и адаптировал определение энтропии к статистической механике. Ближе к тому, что подразумевает этот термин сейчас, он описывает энтропию как измерение всех возможных микро-состояний в системе, макроскопическое состояние которой было изучено. Как могут измениться все наблюдаемые свойства системы? Сколькими способами? Эти вопросы охватывают понятие беспорядка, которое лежит в основе одного из понятий энтропии.

Находится ли Вселенная в состоянии энтропии?

Еще в 19 веке Рудолф Клаузиус вывел, что энергия Вселенной постоянна, а ее энтропия имеет тенденцию к увеличению с течением времени.

По мнению космологов, затем эта точка «взорвалась», расширяясь и распространяясь со скоростью, превышающей скорость света, и породив все частицы, античастицы и излучения во Вселенной.

Конечно, для этого должно было произойти огромное количество процессов связанных с изменением энтропии. Однако если мы подумаем о непрерывном увеличении энтропии, которое происходило на протяжении всех этих лет, то сможем сделать вывод, что энтропия Вселенной сейчас должна быть намного больше. На самом деле, согласно расчетам, энтропия Вселенной сегодня примерно в квадриллион раз больше, чем во время Большого взрыва.

Почему энтропия Вселенной растет?

Черные дыры обладают огромной концентрацией массы, которая обеспечивает им исключительно сильное гравитационное поле. Поэтому они допускают множественность микросостояний. В связи с этим Стивен Хокинг предположил, что черные дыры выделяют тепловое излучение вблизи своих горизонтов событий. Это излучение Хокинга может привести к потере массы и окончательному испарению черных дыр.

Но помните, что черные дыры подчиняются второму закону термодинамики, который гласит, что энтропия всегда будет иметь тенденцию к увеличению. Поэтому они будут набирать все большую массу и сливаться с другими черными дырами, превращаясь в сверхмассивные чёрные дыры. А когда они в конце концов распадутся, излучение Хокинга, создаваемое распадающимися чёрными дырами, будет иметь такое же количество возможных состояний, как и сама ранее существовавшая черная дыра. Согласно этой точке зрения, ранняя Вселенная имела низкую энтропию из-за меньшего количества или гораздо меньших размеров черных дыр.

Существует ли предел энтропии во Вселенной?

Как бы мы ни говорили о тенденции к увеличению энтропии, законы термодинамики также подразумевают состояние максимальной энтропии.

В повседневной жизни мы можем наблюдать это, когда наш кофе остывает в чашке. Когда кофе достигает комнатной температуры, это означает, что он находится в тепловом равновесии с окружающей средой. В кипящей воде, используемой для приготовления кофе, было много возбужденных атомов, но они замедлились и в конце концов достигли максимальной энтропии для данной системы.

При постоянной, стабильной температуре во всем космосе больше не останется энергии для совершения работы, так как энтропия достигнет максимального уровня. Все эти предположения составляют теорию тепловой смерти Вселенной. Эта теория также известна под названием «Большой заморозки», поскольку в этом сценарии энтропия Вселенной будет постоянно возрастать, пока не достигнет максимального значения. В этот роковой момент все тепло в нашей Вселенной будет распределено абсолютно равномерно, не оставляя места для полезной энергии.

Может ли энтропия Вселенной уменьшиться?

Можно с уверенностью сказать, что энтропия во Вселенной в какой-то момент уменьшилась, потому что в ней существует определенный порядок. Гравитационные взаимодействия могут к примеру превращать туманности в звезды. Это своего рода порядок.

Энтропия может уменьшаться без нарушения второго закона термодинамики до тех пор, пока она увеличивается в других частях системы. В конце концов, второй закон термодинамики не говорит, что энтропия не может уменьшаться в определенных частях системы, а только то, что общая энтропия системы имеет естественную тенденцию к увеличению.

При этом общая энтропия Вселенной не уменьшается. Как было сказано выше, энтропия будет иметь тенденцию к увеличению, пока не достигнет своего максимального уровня и не приведет к тепловой смерти. Это стационарное состояние термодинамического равновесия, в котором энтропия не только максимальна, но и постоянна, и она будет оставаться такой, пока не произойдет приток энергии, который оживит систему.

Тогда цикл может повториться. С новой, дополнительной энергией, совершающей работу, останется часть энергии, не способной совершить работу, которая превратится в тепло. Это снова увеличит энтропию системы. Но откуда возьмется эта энергия? Что заставит оставшиеся лептоны и фотоны, если таковые имеются, взаимодействовать?

Что означает энтропия простыми словами?

В современном мире статистическая наука является неотъемлемой частью в жизни каждого общества. Она дает возможность определить динамику развития любого явления или процесса. Одной из вероятностных статистических величин, с помощью которой можно объяснить практически все процессы человеческой жизнедеятельности как социальные, так и индвидуальные, является энтропия. Что же означает простыми словами этот многогранный термин?

Определение

Энтропия (в переводе с древнегреческого – поворот, превращение) – это мера, степень неупорядоченности (хаоса) какой-либо системы. Используется в следующих точных и естественных науках:

История возникновения

Впервые понятие энтропии было введено в эпоху развития термодинамики, когда возникла необходимость в изучении процессов, происходящих внутри термодинамических тел. В 1865 году ученый-физик из Германии Рудольф Клаузиус этим термином описал состояние системы, в котором теплота имеет способность преобразовываться в иные виды энергии (механическую, химическую, световую и т.д.).

Прирост энтропии вызван притоком тепловой энергии в систему и связан с температурой, при которой этот приток возникает. Необходимость этой величины была вызвана тем, что вся физика строится на идеализации абстрактных объектов (идеальный маятник, равномерное движение, масса и т.д.).

В бытовом понимании энтропия представляет собой степень хаотичности и неопределенности системы: чем больше в системе упорядоченности, и чем больше ее элементы подчинены какому-либо порядку, тем меньше энтропия.

Пример: Шкаф – это определенная система. Если в нем все вещи лежат на своих местах, то энтропия меньше. Если же все вещи разбросаны и лежат не на своих полках, то соответственно она становится больше.

С этим термином тесно связана тепловая функция энтальпии – характеризует состояние термодинамической системы в состоянии равновесия при выборе ряда независимых переменных, таких как давление, энтропия и число частиц.

Величина, противоположная энтропии, называется экстропией.

Виды энтропии

Рассмотрим подробнее виды энтропии в каждой из областей ее применения.

В термодинамике

В термодинамике (физической химии) энтропия – это та степень, в которой реальный процесс отклоняется от идеального. Основной постулат термодинамики, сформулированный физиками на базе изучения энтропии: каждая система термодинамики, которая изолирована от внешнего мира, постепенно становится равновесной и впоследствии не имеет возможности выйти самостоятельно из состояния равновесия. Беспорядок – основная характеристика состояния любой системы. Из него она стремится к равновесию.

Возникает вопрос: с помощью чего определить степень беспорядка?

Основной метод: каждому возможному состоянию системы присваивается число вариантных комбинаций, которыми это состояние может быть реализовано.

Вывод: чем больше число вариантов, тем больше величина энтропии. Чем больше организованности в структуре вещества, тем меньше его неупорядоченность.

Абсолютная величина энтропии равна приращению имеющейся в системе тепловой энергии в условиях теплопередачи при заданной температуре.

Клазиус определял энтропию как совокупность приведенных тепловых энергий, как функцию состояния системы, которое остается неизменным в условиях замкнутости, а в условиях открытых необратимых процессов – оно всегда положительно изменяется. Ее значение отражает связь между макро- и микросостояниями. Это единственная функциональная величина, показывающая направленность процессов. Но она не показывает сам процесс перехода состояний из одного в другое, а находится лишь исходным и итоговым состоянием системы.

В экономике

Коэффициент энтропии дает возможность проанализировать уровень концентрации рынка и его изменение. Чем этот коэффициент ниже, тем меньше неопределенность внешней среды, что ведет к повышению вероятности возникновения монополий. Этот показатель выступает в качестве косвенного помощника в оценивании выигрыша, который получает предприятие в ходе ведения монополистической деятельности или в условиях изменения рыночной концентрации (влияет на число потенциальных конкурентов фирмы).

В информатике или статистической физике

Информационная энтропия – это степень непредсказуемости информационной системы. Этот показатель служит для определения степени хаотичности эксперимента, который проводится или произошедшего события. Значение хаотичности прямопропорционально числу состояний, нахождение системы в которых возможно. Все действия, направленные на упорядочивание системы, ведут к появлению информационных сведений о ней и снижают информационную неопределенность, которая выявляет пропускную способность информационного канала, обеспечивающую надежность и достоверность передачи информационных данных. Это позволяет прогнозировать частично возможный ход эксперимента, т.е. предсказывать вероятность того или иного события.

Пример: расшифровка закодированного текста. Для этого анализируется вероятность возникновения того или иного символа и высчитывается величина их энтропии.

В социологии

Энтропия – показатель, характеризующий отклонение общественной системы или ее составных частей от заданного (образцового) состояния. Проявления этого отклонения:

Пример: персонал организации настолько загружен бумажной работой (составлением отчетов, ведением документации), что не может успевать выполнять свои должностные функции и обязанности (осуществление аудита). Мера неэффективного использования трудовых ресурсов собственником предприятия – это информационная неопределенность.