Что такое проверить url

Чем может быть полезен инструмент «Проверить URL» от Яндекса?

Проверка урл`ов в Яндексе

В последние несколько месяцев Яндекс не устаёт радовать чем-нибудь новым. Недавно — 12 февраля 2014 года — в Я.Вебмастере появился новый инструмент — «Проверить URL».

Вещь весьма полезная. Нужна она, прежде всего, для устранения технических ошибок на сайте («неожиданные» редиректы, «не те» коды ответа) и проверки индексации конкретной страницы в Яндексе.

Но кроме описанных в документации задач, которые выполняет данный инструмент, есть у него и ещё одна не очень явная полезность, о которой напишу чуть ниже. А сначала — немного о самом инструменте.

Что такое инструмент «Проверить URL» от Яндекса?

Он поможет получить информацию об индексировании:

известен ли роботу адрес страницы, начала ли она индексироваться и есть ли с нее перенаправления.

В общем, в блоге всё написано. Также можно заглянуть в Яндекс.Помощь.

Как использовать «Проверить URL»?

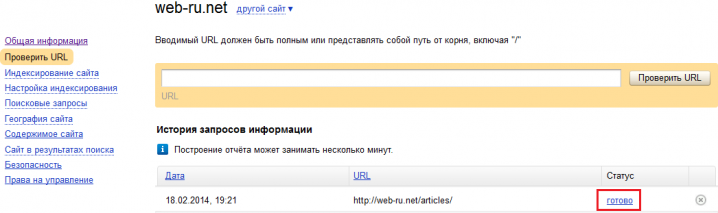

Инструмент проверки URL в Яндексе (кликабельно)

Кликаем на «готово» — и смотрим:

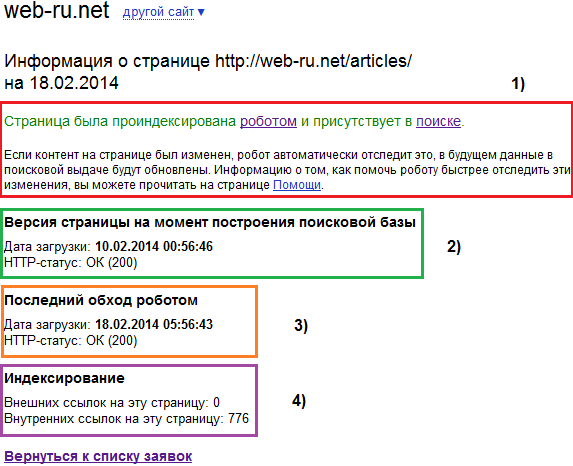

Что здесь есть (для страницы http://web-ru.net/articles/ ):

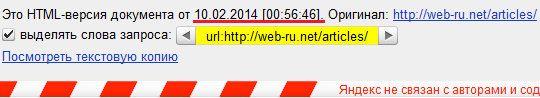

Время и дата последнего помещения страницы в кэш Яндекса

В общем, если со страницей всё в порядке, то такая картинка и должна быть. Если же страница переадресует на другие URL, или выдаёт код ответа, отличный от 200 — то, значит, с ней не всё хорошо. Можно почитать:

В чём ещё польза инструмента «Проверить URL»?

В Яндекс.Помощи есть интересная фраза:

Если всё действительно так, то это очень хорошо. Потому что для многих сайтов существует проблема «медленной переиндексации страниц».

Например, вы решили подправить контент на сайте и его структуру — но робот Яндекса даже спустя месяц не переиндексировал страницу. Так что теперь можно отправить URL страницы в форму этого инструмента.

Особенно полезно это будет для продавцов вечных ссылок. Т.к. проставленная ссылка оплачивается только при условии индексации Яндексом в течении какого-то времени (45 дней — стандартное время для популярной биржи GoGetLinks), то будет очень хорошо, если страница со ссылкой проиндексируется в следующий же апдейт Яндекса.

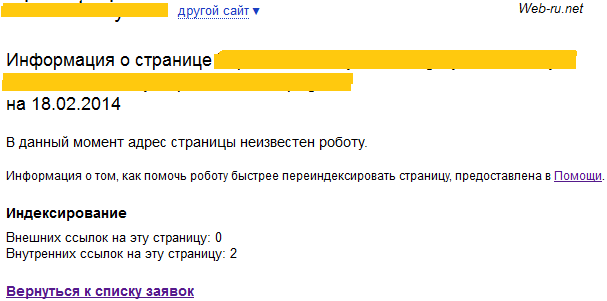

Таким образом, инструмент полезный. К сожалению, сложно сказать — ускоряет ли он индексацию совсем новых страниц. После добавления не известной Яндексу страницы я получил следующее:

«Проверить URL» в Яндексе — новая страница

Если бы он ускорял индексацию совсем свежих страниц — было бы просто замечательно!

В общем, «Проверить URL» — действительно полезный инструмент от Яндекса, использовать стоит. Может помочь как в техническом анализе страниц, так и для ускорения их переиндексации.

URL адрес — что это такое и как узнать урл веб-страницы сайта, изображения или видео

Здравствуйте, уважаемые читатели блога Goldbusinessnet.com. Продолжаем изучение важнейших составляющих интернета, и на очереди у нас понятие «URL адрес» (урл по-простому), который юзеры вводят в адресную строку браузера (какой из них лучше?) в чистом виде.

И именно URL является тем базовым параметром атрибута href, с помощью которого создаются гиперссылки, входящие в состав гипертекста как основы Мировой Паутины. Благодаря урлу все пользователи получают возможность посетить нужный сайт и получить искомую информацию.

По большому счету, «URL» связан с терминами «URI» и «URN», краткое объяснение сути которых будут, безусловно, даны в соответствующем разделе настоящей публикации.

Кроме этого, разберем на наглядных примерах, из чего состоят урлы, какого вида они бывают и как находить адреса изображений, страниц сайта, видео и копировать их для своих нужд.

Что такое URL адрес и из чего он состоит?

Итак, начнем с самого начала, то есть с URI (Uniform Resource Identifier), аббревиатура которого в переводе с английского означает «Унифицированный идентификатор ресурса». Это уникальный набор символов, позволяющий идентифицировать любой ресурс в интернете: страницу вебсайта, файл, электронный почтовый ящик и т.д.

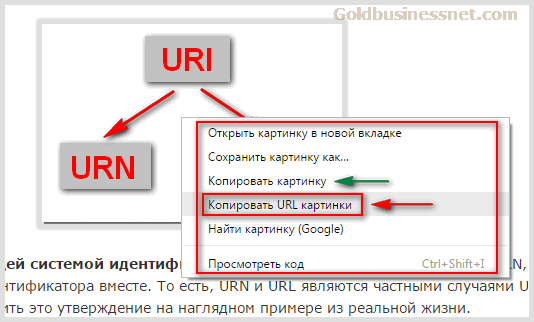

Составляющими URI являются URN (Uniform Resource Name — Унифицированное Наименование Ресурса) и URL (Uniform Resource Locator — Унифицированный Указатель Ресурса). Первый из них идентифицирует конкретный проект по его названию в пространстве имен, а второй указывает на его местоположение в интернете и обеспечивает доступ к нему посредством конкретного метода. Схематически это соотношение можно изобразить следующим образом:

URI является более общей системой идентификации. Она может включать в себя либо URN, либо URL, либо оба идентификатора вместе. То есть, URN и URL являются частными случаями URI. Попробую объяснить, что значит каждый термин, на наглядном примере из реальной жизни.

Допустим, имеется конкретный адрес (г. Нижний, ул. Верхняя, д.4, кв.15), до которого возможно добраться различными способами в зависимости от степени удаления пункта отправления. Имя владельца квартиры Василий Васильевич Пупкин.

Ну а полная информация, включающая адрес и имя находящегося по этому месту жительства человека — URI. Конечно, это в известной степени упрощенние, но зато оно помогает постичь суть без излишнего напряжения мысленных ресурсов.

Нас интересует в первую очередь унифицированный указатель, поскольку именно он является основной идентификационной системой, используемой широко на практике в глобальной сети. Поэтому далее мы и уделим основное время описанию структурных особенностей URL.

Структура УРЛ и некоторые особенности для вебмастеров

Итак, мы с вами определили в общих чертах, что же такое URL адрес. Это путь до любого файла (вебстраницы сайта, картинки, видео и др.). Начнем с простого примера. Вот как может выглядеть локатор в общем виде для одного из файлов, находящегося в определенной директории (папке):

В качестве реального примера привожу урл адрес файла, который содержит логотип этого блога:

Чуть выше я упомянул, что URL содержит не только указание на конкретное местоположение объекта в сети, но и то, каким способом можно получить к нему доступ. Так вот, протокол HTTP, стоящий в самом начале унифицированного указателя, как раз и является инструментом, который помогает открыть файл по указанному адресу в браузере.

У протокола передачи данных HTTP есть вариант HTTPS, обеспечивающий безопасное соединение и к переходу на который в последнее время склоняют вебмастеров поисковики (что, впрочем, будет благом для всех, особенно для коммерческих веб-ресурсов и проектов, где используется передача персональных данных пользователей).

Но вернемся к нашему примеру. После обозначения типа протокола «http://» (а в общем случае способа доступа, поскольку в урлах не всегда применяется протокол, но об этом ниже) идет уникальное название домена (читайте о доменных именах и о том, как их зарегистрировать). Кстати, доменное имя может быть указано и с WWW:

Тогда наблюдается присутствие в интернете двух разных ресурсов (с WWW и без) с одинаковым содержанием. С точки зрения поисковых систем это зеркала, являющиеся по своей сути дублями, которые жутко мешают продвижению проекта как в Яндексе, так и в Гугле.

К тому же, обратные ссылки, проставленные на ваш сайт с доноров, могут быть распределены в неизвестных пропорциях между зеркалами. Поэтому надо предпринять действия по определению главного домена и склейке зеркал, в том числе посредством 301-ого редиректа.

С доменным именем мы разобрались. Кстати, при создании сайта домен вашего веб-проекта будет считаться корневой папкой с точки зрения файловой структуры веб-сервера. Вследствие этого цепочку после двойного слеша можно воспринимать как последовательность вложенных друг в друга папок (их может быть несколько), где на конце урла находится нужный файл:

Этот файлик идентифицируется по названию и расширению, в нашем примере это «file.extension». Причем, расширение может быть самым различным (html, php, png и т.д.).

Но здесь надо иметь ввиду, что на веб-серверах во многих случаях используются Unix-подобные ОС, где, в отличие от Windows, расширения для файлов не являются обязательными и часто не применяются, поэтому запись «file.extension» может вполне быть принята за название файлика с точкой посередине. Эта информация нам может пригодиться в дальнейшем.

Для полноты картины нужно еще упомянуть об адресах страниц сайтов в интернете. Чаще всего встречаются урлы трех видов (ЧПУ), которые наиболее предпочтительны во всех смыслах:

Вроде бы, первый вариант больше всего отвечает разобранной нами схеме. Но в случае с URL страницы не все так однозначно. В теории это состоит следующим образом (попробую объяснить все на примере обычного блога, по-моему, он достаточно наглядный и понятный большинству).

Основываясь на приведенном мною в самом начале данного раздела статьи общем примере урла, возможно было бы рассуждать следующим образом. В соответствии с иерархией в блоге роль подпапок играют разделы (рубрики или категории) вебресурса, в которые включены отдельные вебстраницы (файлы). Ну а главная страница — это основная папка (корень сайта в файловой структуре сервера), содержащая рубрики.

При стандартных серверных настройках каждый URL, соответствующий каталогу (папке), должен заканчиваться слэшем, в этом случае обработчик «поймет», что необходимо отобразить листинг всех файлов, которые там содержатся, а не какой-то конкретный объект, поиск которого будет осуществляться, если слеша не будет (таким образом вы экономите ресурсы сервера).

В соответствии с этими рассуждениями локатор главной должен заканчиваться на «/», поскольку домен является корневой директорией:

По этой же причине такой же вид урла соответствует рубрикам сайта:

А вот статические или страницы записей выводятся в таком обличье:

Помните, чуть выше я упоминал о двух легитимных вариантах существования файлов в Unix-подобных операционных системах (с расширением и без)?

Если взять в качестве образца самый популярный в мире движок WordPress, то там все шаблоны, отвечающие за формирование различных страничек сайта (главной, рубрик, вебстраниц записей и т.д.) входят физически в одну директорию текущей темы.

Таким образом, содержание названных страниц в конечном виде существует лишь при просмотре в веб-браузере, а не физически на сервере. К слову, с файловым строением тем WP вы можете познакомиться перейдя по ссылке, этот материал даст вам дополнительные полезные сведения.

Кто привык копать глубоко и желает более подробно изучить этот архиважный аспект, отсылаю вас к очень качественному материалу, где он освещается на основе первоисточника в формате спецификации общего синтаксиса URL, и в котором красной нитью проходит утверждение, что урл вообще (вне зависимости от своего содержания) указывает на абстрактное местоположение ресурса, а не на его конкретное физическое расположение.

Более того, ни один из них не имеет сколь-нибудь заметного преимущества в глазах поисковых систем. Единственное, для обеспечения правильной индексации надо также установить 301 редирект в случае применения URL со слешем или без в конце.

Надеюсь, что предоставленная информация поможет вам определиться с настройкой урлов на своем сайте. Для проектов, работающих на WordPress, например, постоянные ссылки сайта можно легко настроить в соответствующем разделе админ-панели.

Важное замечание! Настройку ссылок желательно производить в начале создания проекта, дальнейшие изменения могут замедлить или приостановить продвижение сайта, поскольку переиндексация у поисковиков не происходит мгновенно.

Выше мы рассмотрели частные случаи различных типов локаторов, ну а общая блок-схема, демонстрирующая структуру URL, выглядит следующим образом:

Пожалуй, следует дать некоторые разъяснения по отдельным составляющим.

Схема. Как я уже отмечал выше, не всегда средством передачи данные служит протокол, хотя это наиболее распространенный вариант. Эту роль вполне может играть псевдопротокол (например, тот же mailto, являющийся средством отправки сообщения по электронной почте):

Для полноты информации вы можете ознакомиться с полным перечнем используемых схем на соответствующей страничке Википедии.

Кроме HTTP и HTTPS вебмастерами и разработчиками очень часто применяется на практике и FTP (тут об этом протоколе необходимые подробности), который очень удобен при работе с файлами своего проекта на сервере хостинга (что это такое и как купить место для сайта), если при этом воспользоваться помощью соответствующей программы (например, Файлзилла).

В таком случае для доступа к нужному файлу или папке понадобиться указать логин и пароль, а также порт (если он отличен от стандартного, применяемого по умолчанию):

Здесь в качестве хоста указано имя домена («goldbusinessnet.com»), но может быть использован и IP-адрес, идентифицирующий устройство в сети интернет (тут о взаимодействии ай-пи адресов, ДНС и доменных имен). Ну а «folder1/file.extansion» — это уточняющий URL-путь до объекта.

Для вебмастеров еще один нюанс заключается в том, что любой движок может генерировать локаторы, в которых присутствуют так называемые GET-параметры, следующие после знака «?» в конце урлов. Если их несколько (каждый может иметь свое значение), они разделяются «&»:

Страниц с такими адресами на сайте может набраться достаточное количество, причем их контент может быть тождественным с основными вебстраницами. Те, кто имеет свои блоги на Вордпрессе, могут столкнуться с ситуацией, когда наличие древовидных комментариев инициирует появление урлов с replytocom (правда, в последних версиях WP, по-моему, эта проблема уже не актуальна):

А это и есть самые настоящие дубли, большое количество которых способно существенно снизить скорость индексирования страничек, а значит, и косвенным образом замедлить продвижение веб- ресурса. Поэтому, думаю, будет уместным в этом месте дать гиперссылку, перейдя по которой вы узнаете, как бороться с самым разнообразным дублированным контентом на Вордпресс.

Если есть цель улучшить навигацию и направить посетителя не просто на нужную страницу, но в определенное место на ней, где есть искомая информация, то используют якорь (по-английски anchor), с помощью которого создаются хеш-ссылки:

К выше сказанному надо бы еще добавить, что в стандартных урлах рекомендуется использовать лимитированную выборку знаков: буквы латинского алфавита в нижнем регистре [a-z], цифры 2, точку [.], нижнее подчеркивание [_], и дефис [-].

Такие ограничения действуют со времени зарождения интернета, но с некоторых пор ввиду развития глобальной сети появилась необходимость формировать URL с применением символов национальных языков, включая русский. Такая возможность появилась, но для ее реализации требуется кодировка (encoding) любых знаков в формате ASCII, который понимают браузеры.

Кодирование и декодирование URL

Итак, после некоторых предпринятых соответствующими международными организациями усилий сайт может использовать для адресов своих страниц локаторы, включающие буквы практически любого языка. Нас интересует русский, поэтому можете проверить сие утверждение, введя в адресную строку браузера урл одной из страниц Русской Википедии:

Адрес корректно отобразится:

А после нажатия кнопки «Enter» откроется соответствующая страничка. Теперь попробуйте скопировать этот адрес в буфер обмена и вставить его в любой документ (например, в блокнот Windows). Получится такой набор:

Это и есть закодированные русские буквы, которые web-браузер автоматически преобразует в читабельный текст на кириллице. Кстати, в сети есть немало сервисов, которые предлагают быстрое кодирование и декодирование содержания URL, например, вот этот:

Конечно, для пользователей рунета гораздо более привлекательным является текст на русском, содержащийся в локаторе (кстати, и доменное имя может быть кириллическим).

Однако, формировать урлы на кириллице для страниц своего сайта я все-таки советую только в том случае, если проект имеет какие-то свои особенности, вследствие которых именно русские символы в URL будут эффективнее привлекать посетителей, особенно целевую аудиторию.

В других случаях все же оптимальнее будет применять латиницу (а для WordPress использовать плагины транслитерации для автоматического преобразования русских букв в постоянных ссылках в латинские), поскольку это исключает некоторые возможные ошибки, а поисковые системы не делают языковых предпочтений в этом аспекте при ранжировании.

Как узнать URL изображения, видео или страницы сайта?

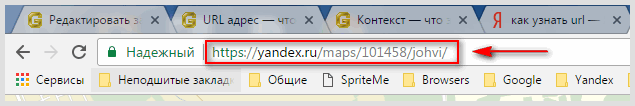

При работе в интернете да и просто во время сёрфинга или поиска информации в сети очень часто нужно просмотреть или скопировать адрес того или иного объекта. Где же взять нужный урл на открытой в браузере веб-страничке? Что касается URL страницы сайта, то его можно подсмотреть в адресной строке:

Правда, если данные передаются по обычному протоколу HTTP, то он, скорее всего, будет скрыт. Однако, если вы выделите урл, щелкните по нему правой кнопкой мышки и скопируете, выбрав из появившегося контекстного меню нужный пункт:

То после его вставки в нужное место он будет отображаться полностью (включая протокол «http://»). В случае использования владельцами веб-ресурса HTTPS локатора, соответствующего защищенному соединению, адрес веб-страницы будет доступен в полном виде сразу же после выделения и последующего клика по нему:

С помощью того же контекстного меню можно найти и скопировать также URL нужной вам гиперссылки, содержащейся в тексте:

Иногда нужно узнать урл размещенной в web-пространстве картинки. Для этого опять используйте тот же метод:

Только имейте ввиду, что если будете «Копировать картинку», то в буфер обмена поместите не ее URL, а само изображение, которое потом можете вставить в необходимое место.

Точно также есть возможность узнать и скопировать адрес видео. Ежели находитесь, например, в пределах Ютуба на странице с видеороликом, то это делается либо из адресной строки браузера, либо в разделе «Поделиться», находящемся чуть ниже ролика:

В случае присутствия видео в контенте веб-странички его URL- адрес можно получить с похожей легкостью (достаточно щелкнуть правой кнопкой мыши прямо по плейеру):

Таким вот образом вы легко можете получать и копировать URL-адрес практически любого объекта. Кстати, контекстное меню может принимать различный вид в зависимости от применяемого веб-браузера, но суть его опций остается практически идентичной.

Лучшие онлайн-сервисы для проверки сайта на вирусы

Все владельцы компьютерных устройств, будь то стационарный ПК, лэптоп или другой гаджет, хотя бы раз сталкивались с вредоносными программами. Известно, что большинство заражений происходит через интернет. Для защиты от угроз используются специальные антивирусные программы, способные эффективно обезопасить наши девайсы.

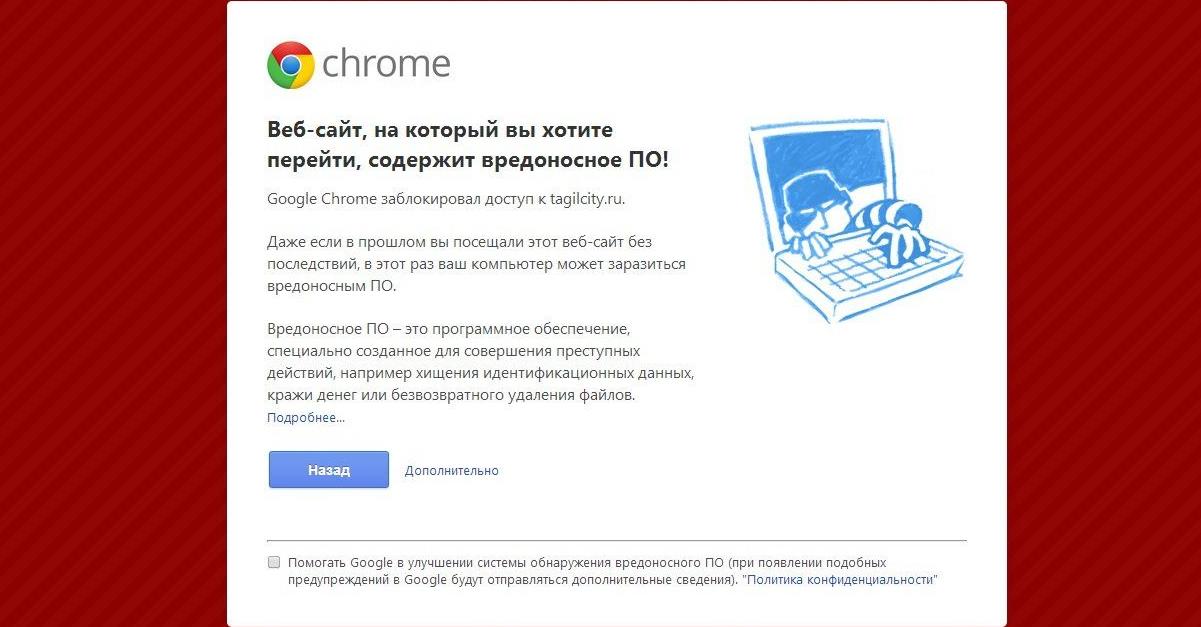

Сложнее дело обстоит с веб-ресурсами, которые находятся в постоянном двустороннем многопользовательском доступе для огромного количества соединений по всему миру. Чем популярнее сайт или блог, тем больший интерес он может вызвать для потенциальных хакерских атак. При правильной настройке политики безопасности даже полный выход из строя компьютера в результате заражения вредоносным ПО максимум приводит к необходимости переустановки ОС и восстановлению данных из бэкапов. Нарушение работы виртуального ресурса может иметь куда более серьезные и даже катастрофические последствия. К ним относится блокировка доступа на уровне домена со стороны поисковиков, сбои в работе сайта, кража персональных данных и многое другое. Все это негативно сказывается на маркетинговом позиционировании ресурса и приводит к падению трафика.

Признаки заражения сайта

Первыми сигналами, говорящими о том, что ваш веб-ресурс столкнулся с проблемами безопасности, являются:

Первое действие, которое необходимо осуществить при появлении подобных сигналов, – это провести полную проверку интернет-ресурса. Проверка на вирусы состоит из двух этапов:

Предположим, вы провели полное сканирование сайта на сервере хостера, устранили или даже не обнаружили вредоносных кодов на проверяемых страницах и в подключаемых файлах. Несмотря на это, проблема осталась, поисковик не снимает блокировку, а посетители по-прежнему сталкиваются с нежелательным редиректом. Дело в том, что статический анализ на наличие вирусных скриптов и кодов не всегда эффективен. Например, вредоносный код может автоматически подгружаться с другого ресурса или выполнять несанкционированные действия при определенных условиях:

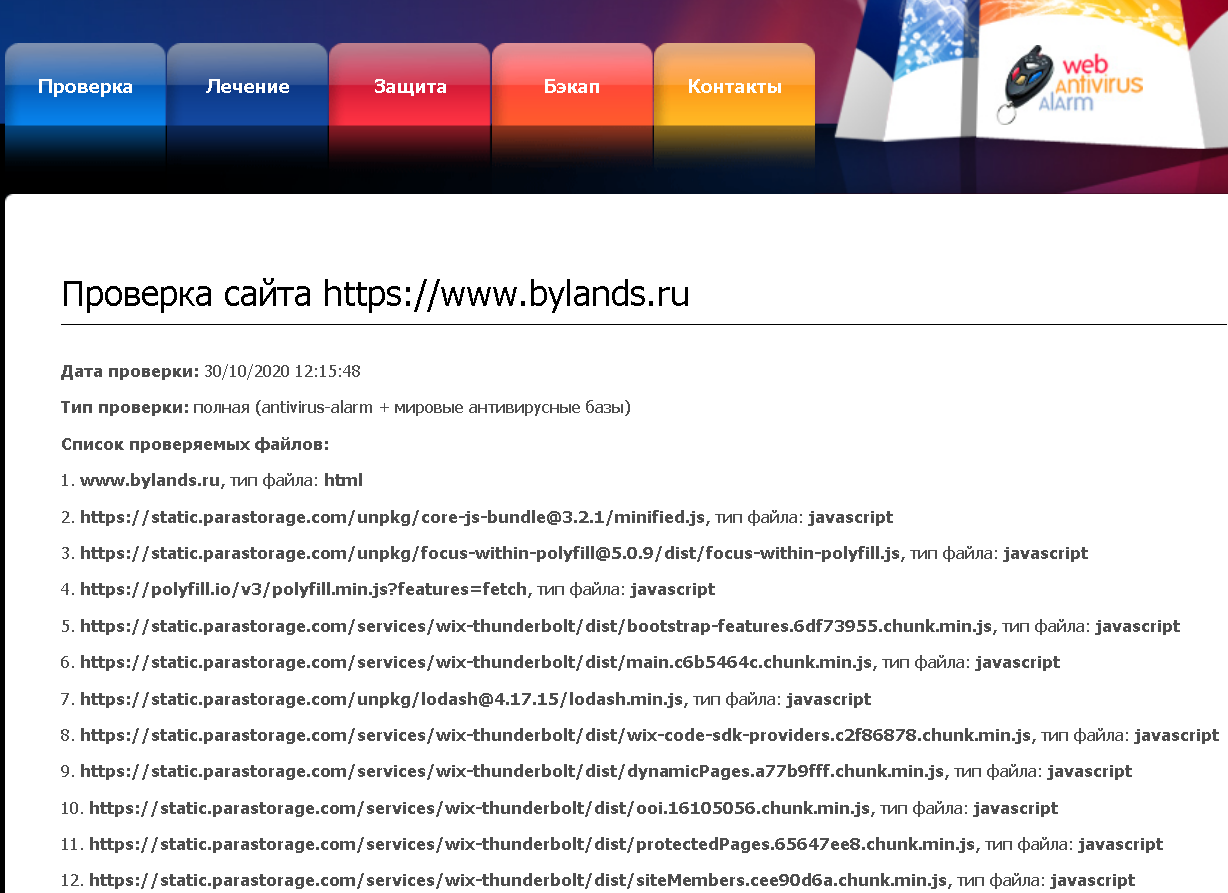

В такой ситуации на помощь приходят веб-сканеры, которые выполняют динамический и статический анализ страниц сайта на вредоносный код. Очевидно, что наличие функционала эмуляции поведенческой активности служит основным критерием при определении наиболее подходящего антивирусного веб-сканера. В данной статье сделаем краткий обзор таких ресурсов. Для наглядности экспресс-тестирования я использую один из сайтов, разработанных мною в CMS-конструкторе WIX.

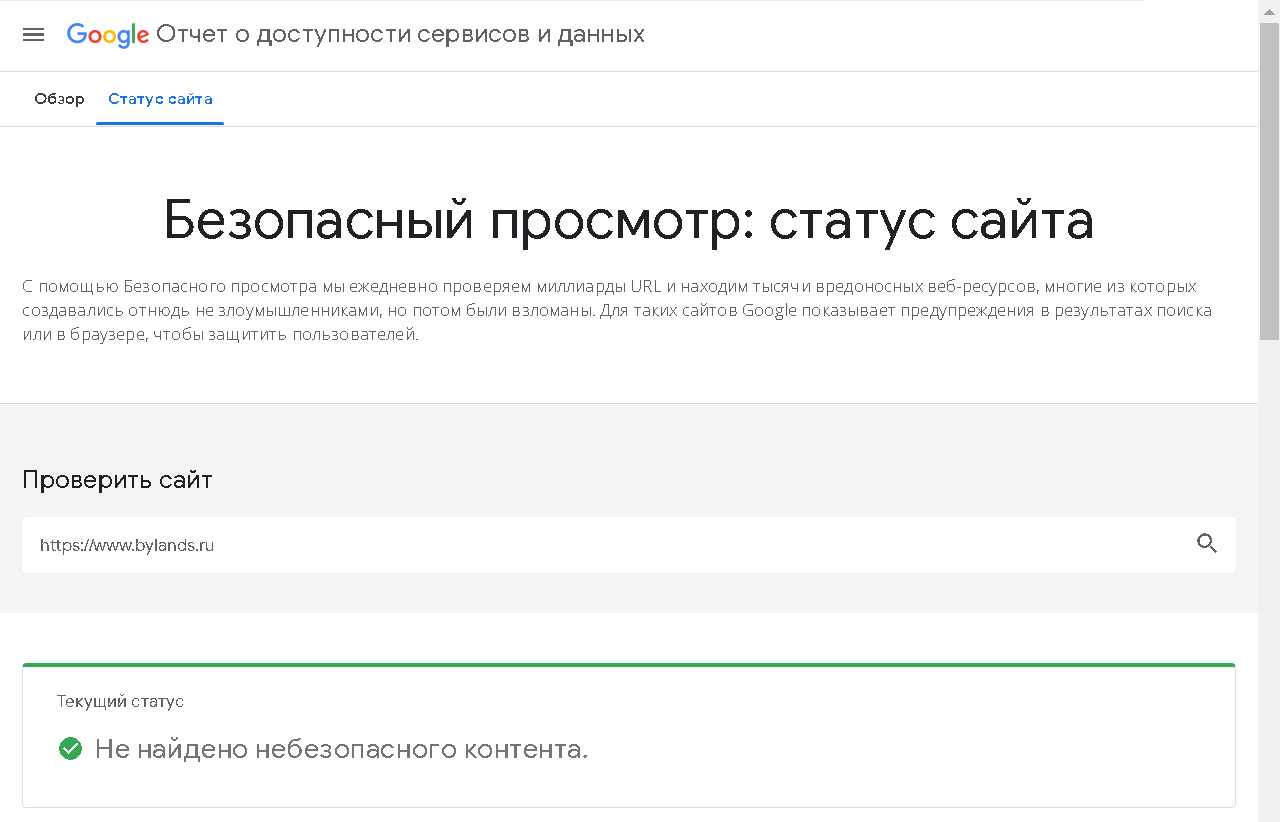

Проверка сайта на вирусы с помощью поисковых систем

Очевидно, что первыми на рубеже обороны находятся наиболее популярные поисковики Яндекс и Google. В процессе индексации сайтов они проверяют их на признаки заражения, блокируют опасное содержимое, ведут и обновляют «черные списки» вредоносных ресурсов. Единственное, что не могут гарантировать поисковые системы – это отсутствие вирусов или троянов в файлах, которые могут быть доступны для скачивания с сайтов. Особенно это касается архивных файлов и различных упаковщиков для исполняемых файлов. Для анализа веб-ресурсов на безопасность каждый поисковик использует собственную систему с мощными алгоритмами проверки:

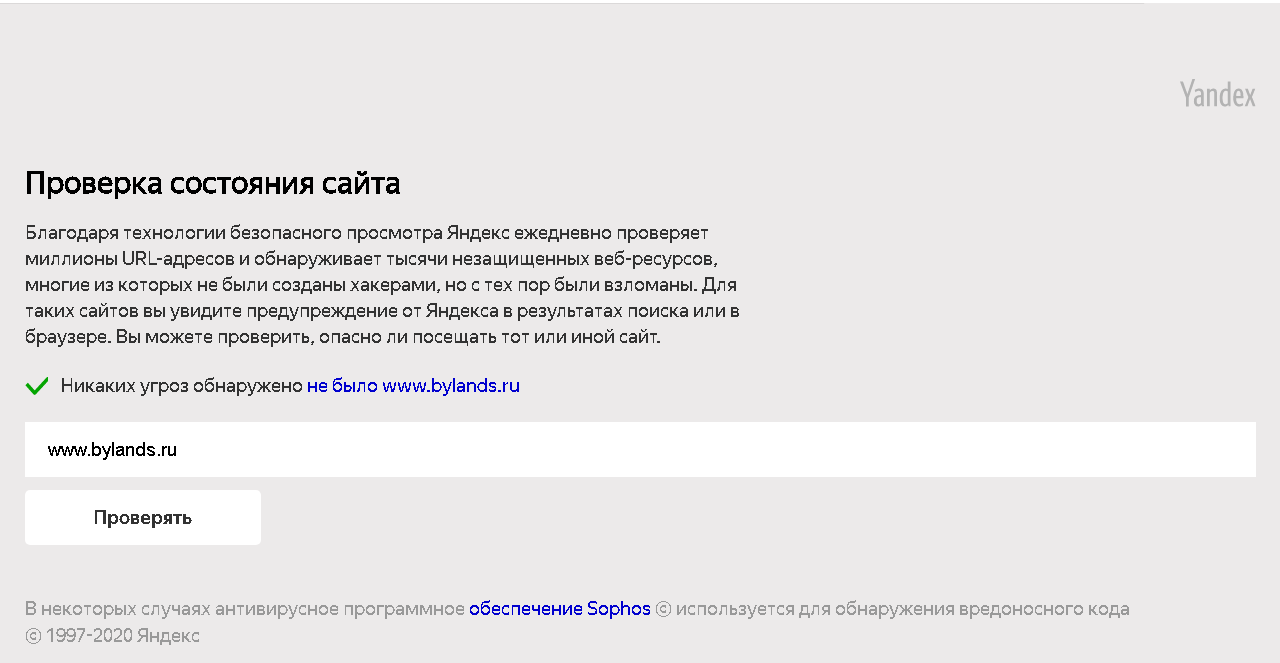

Интересно, что российский Яндекс, при переходе по ссылке на Yandex Site status check, открывает страницу с инструкцией на английском языке, которую можно русифицировать в Яндекс Браузере, в то время как «Google безопасный просмотр» сразу открывается с русским текстом.

Несмотря на высокую эффективность проверки данными сервисами, у них есть свои недостатки. Алгоритмы Yandex Site status check и «Google безопасный просмотр» обладают определенной латентностью и могут не сразу показать угрозу.

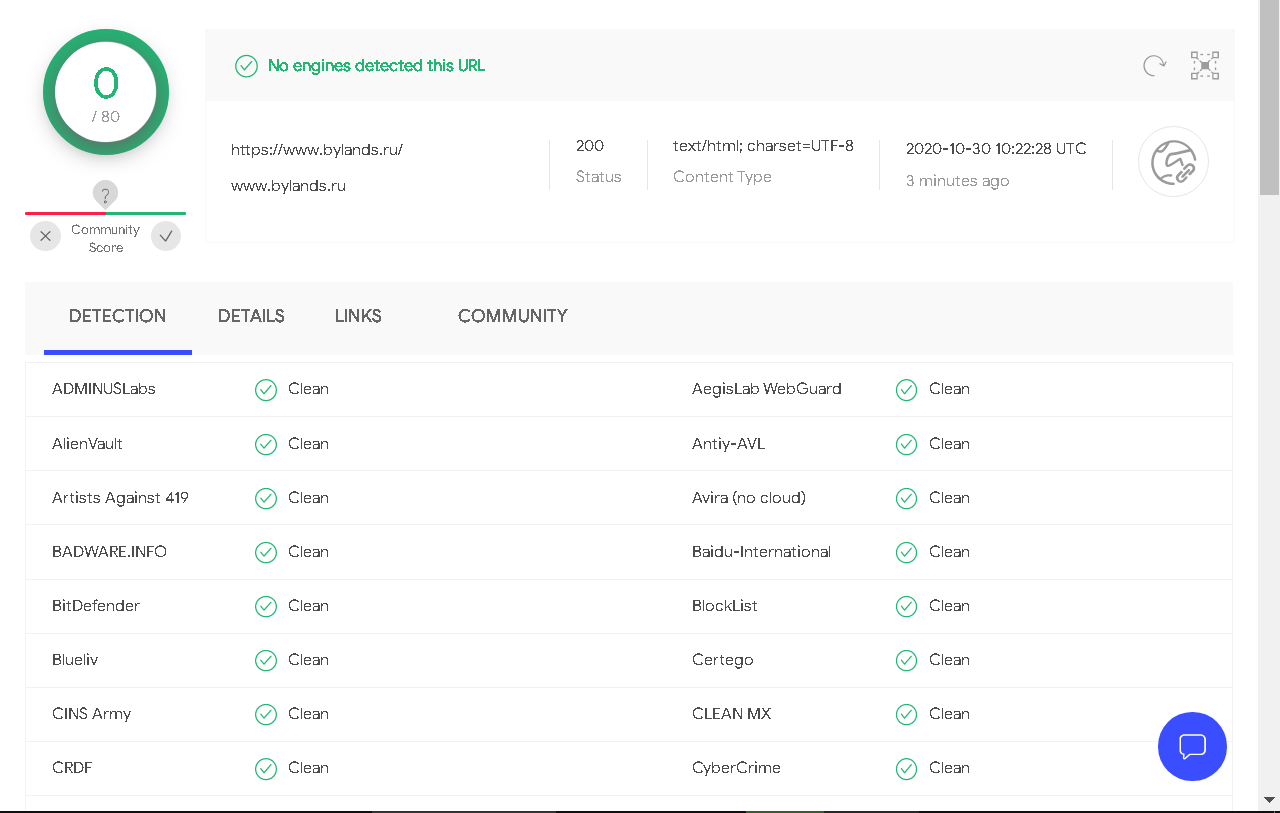

Тестовая проверка нашего веб-сайта данными программами показала его полную безопасность.

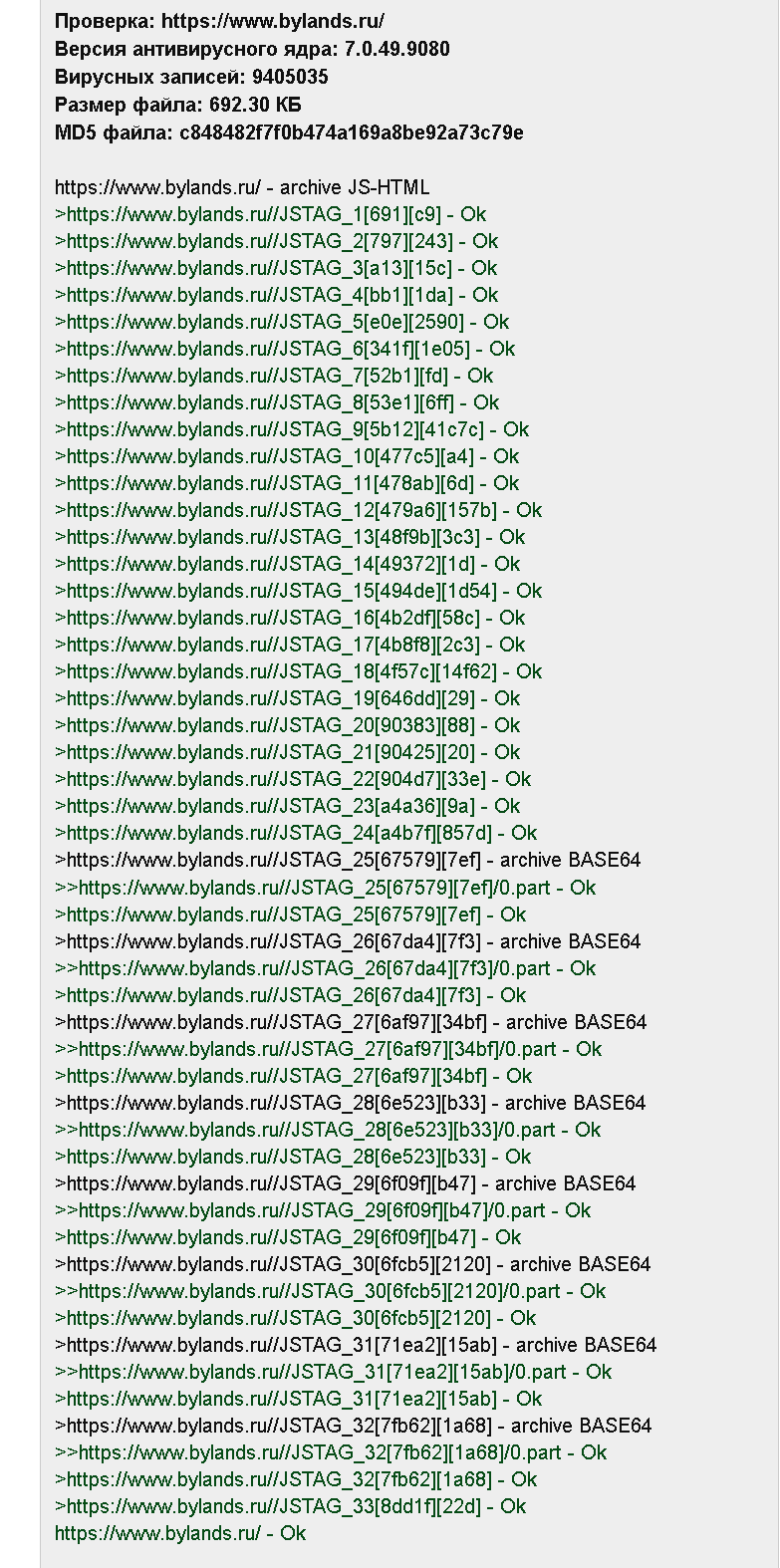

Результат проверки Yandex Site status check:

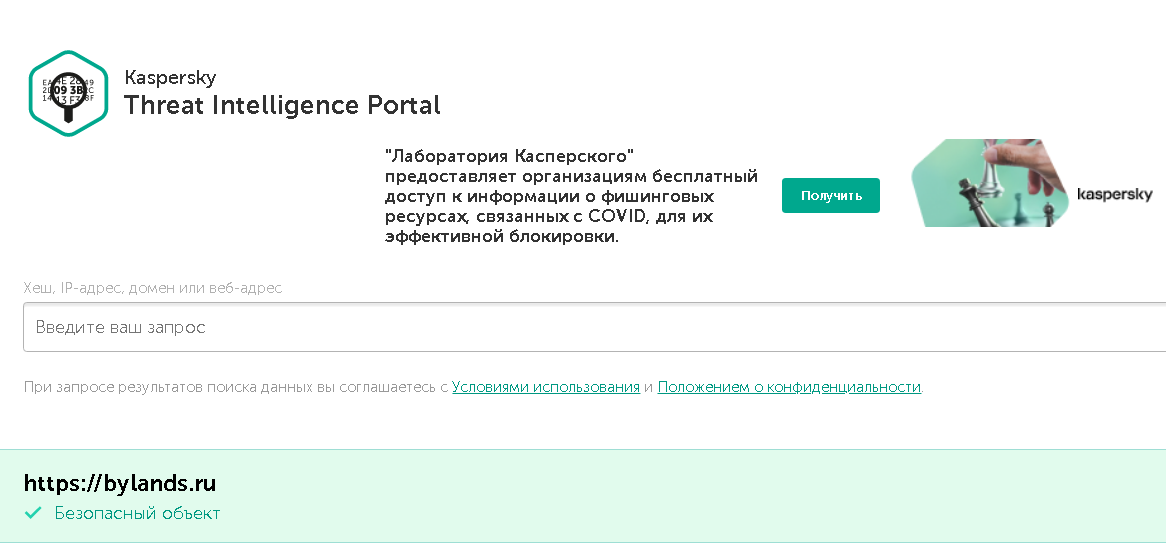

Kaspersky VirusDesk

Один из наиболее популярных отечественных антивирусов выполняет в том числе бесплатную проверку веб-ресурсов. Результат предоставляется в виде отчета о репутационной базе сайта и содержит три возможных статуса: плохая, хорошая или неизвестная репутация.

Доступна проверка файлов размером до 50МБ, которые можно подгружать простым перетаскиванием мышью. Продукт Лаборатории Касперского содержит существенный недостаток: текущее содержимое сайта не проверяется, поэтому репутация ссылки, основанная на ранее полученных данных, не отражает актуальное состояние дел. Ресурс может быть заражен пару дней назад, а репутация у него до сих пор останется хорошей.

Dr.Web онлайн

Система проверяет адрес в сети интернет, для чего достаточно ввести URL сайта в соответствующее окошко. При добавлении формы онлайн-проверки файлов и ссылок (URL) в код сайта предоставляется возможность проверки ресурса на безопасность посетителями сайта. При установке на мобильное устройство Dr.Web Security Space для Android с компонентом URL-фильтр есть возможность ограничить доступ к нерекомендуемым и потенциально опасным сайтам по нескольким категориям. Данная опция предоставляется при платной подписке на антивирусное ПО.

Доктор Веб проверяет самые уязвимые файлы и выдает отчет по ним. В нижней части отчета будут находиться результаты проверки по свежим антивирусным базам Dr.Web:

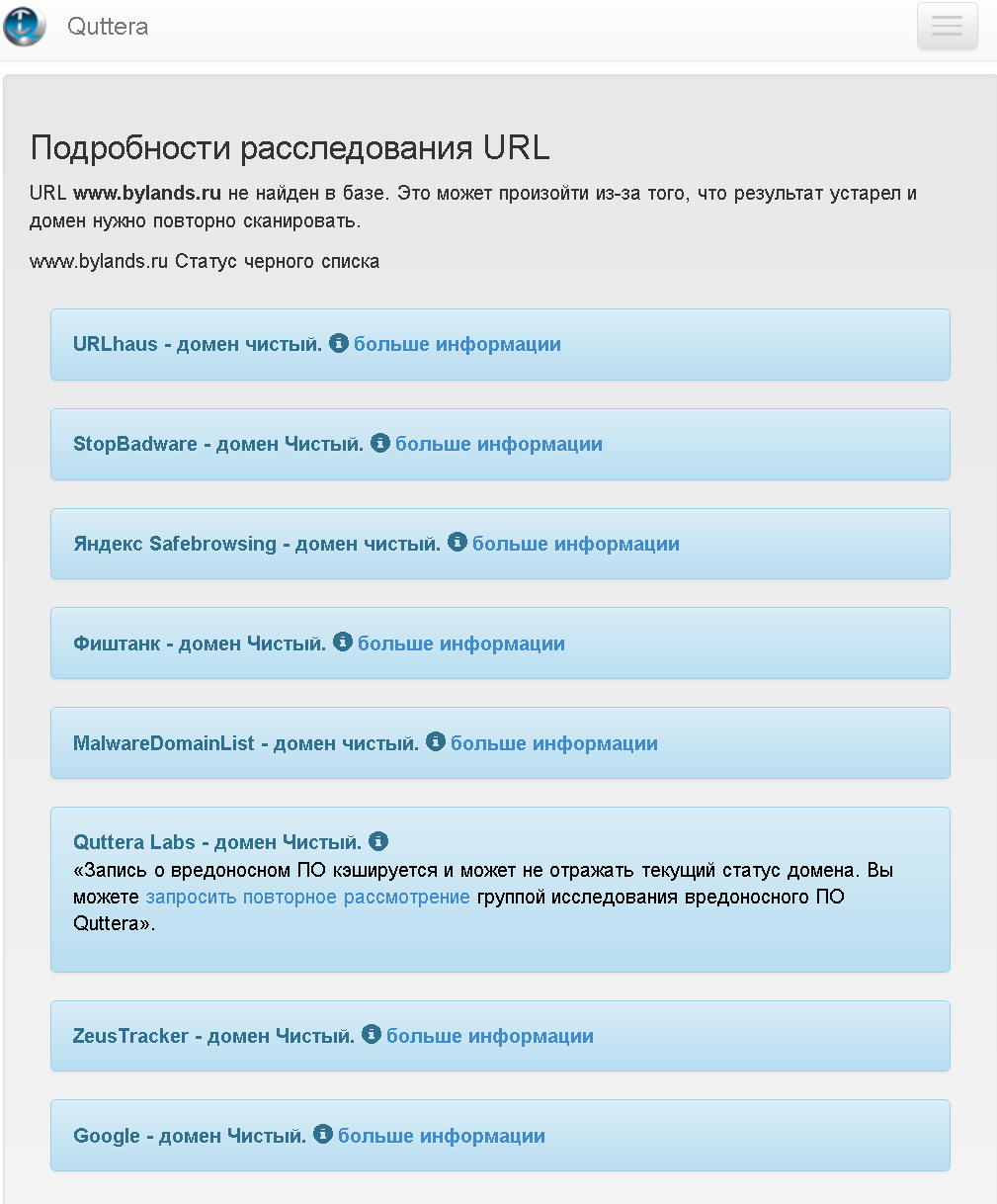

Веб-сканер QUTTERA

Бесплатный ресурс, ориентированный на зарубежные сайты с их характерными заражениями, достаточно эффективен и при проверке доменов рунета. Выполняет динамический анализ сайта, что позволяет обнаруживать 0-day угрозы. Возможна проверка сразу нескольких страниц. Любопытно, что сервис в разряд потенциально подозрительных файлов отнес код Яндекс.Метрики (mc.yandex.ru/metrika/watch.js).

Quttera не только анализирует файлы на наличие троянов, но и проверяет репутацию ресурса и его наличие в черных списках таких баз, как:

Процесс проверки может занять несколько минут.

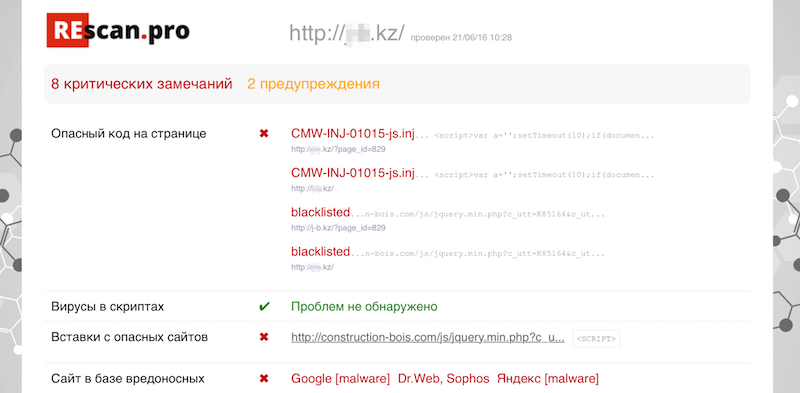

Веб-сканер ReScan.pro

Проводит статический и динамический анализ сайта. Поведенческий анализ выявляет скрытые редиректы. Статический анализ находит вирусные фрагменты на страницах и в загружаемых файлах. Кроме основного URL проверяет смежные страницы сайта, в т.ч. по внутренним редиректам. Также проверяет сайт на присутствие в блэк-листах Яндекс, Google и VirusTotal. Количество запросов с одного IP-адреса лимитировано тремя проверками в сутки. Интерфейс сервиса русифицирован.

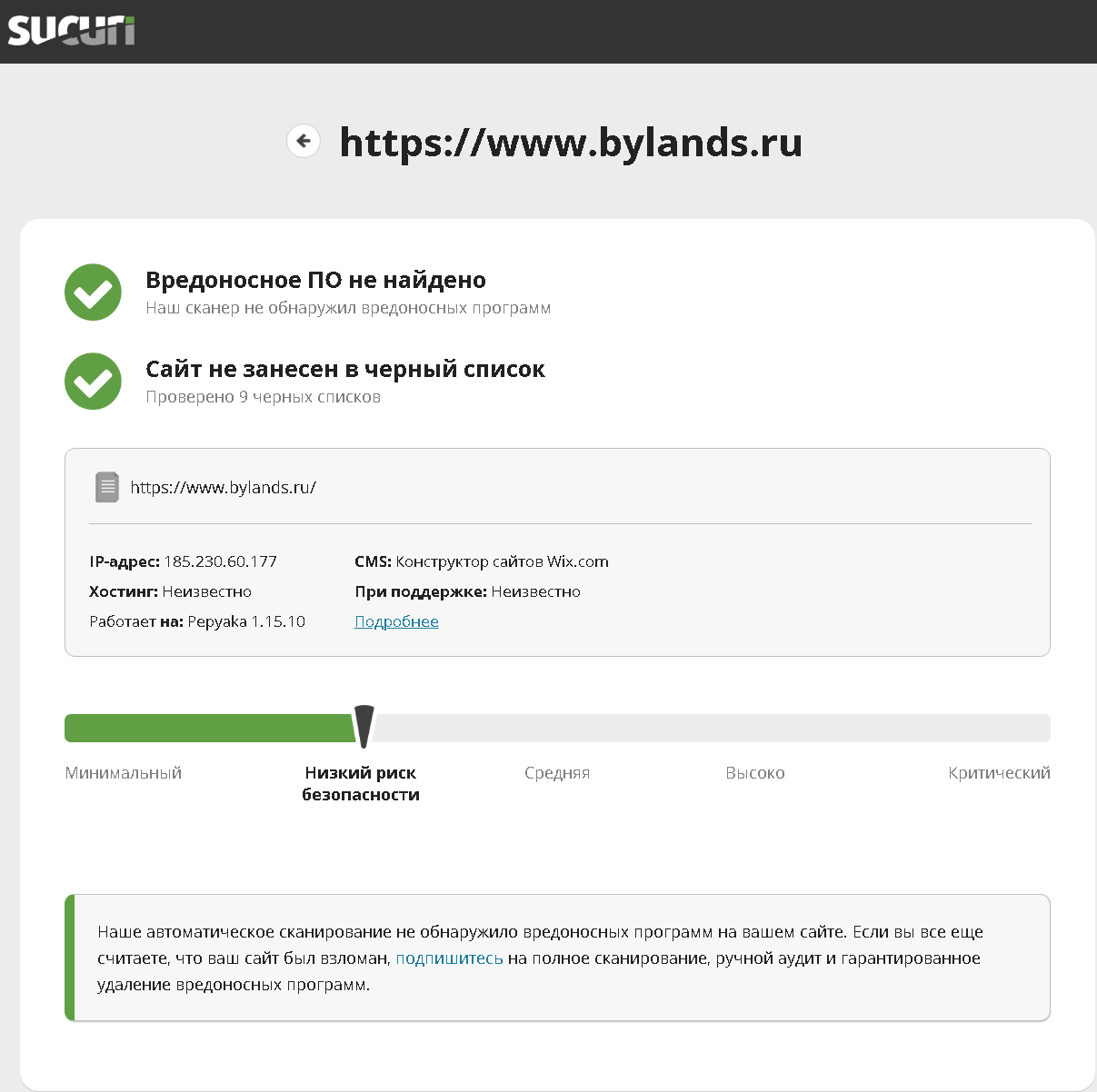

Веб-сканер Sucuri

Проводит эвристический анализ, находит вирусный код по сигнатурам. Обнаруживает спам-ссылки, дорвей-страницы, опасные скрипты. Отправляет запросы к нескольким URL на сайте с различными User Agent/Referer. Проверяет актуальность версий CMS и веб-сервера. В основном ориентирован на анализ репутации сайтов и проверку наличия в блэклистах. Предоставляет достаточно развернутый отчет по нескольким параметром с рекомендациями.

VirusTotal

Один из наиболее популярных бесплатных сервисов онлайн-проверки файлов и URL выполняет поиск и сканирование по ip-адресу. VirusTotal является агрегатором нескольких десятков антивирусов и антивирусных сервисов. Сканер можно добавить в закладки браузера для проведения быстрой проверки веб-ресурса. Обновление антивирусной базы происходит в автоматическом режиме, что делает VirusTotal одним из наиболее надежных сервисов проверки сайтов. Проводит анализ файлов по 65 популярным базам и выдает суммарный результат.

Интерфейс сканера не русифицирован, но достаточно прост в освоении.

Antivirus Alarm

Сканер проводит проверку файлов и ссылок на наличие вредоносного кода. Сам процесс занимает достаточно продолжительное время, но результат того стоит. Приятный бонус «проверялки» – полностью русскоязычный интерфейс.

По результатам сканирования Antivirus Alarm дает подробнейшую инструкцию о том, как самостоятельно удалить вирус с сайта, а также оказывает помощь в данном вопросе на платной основе.

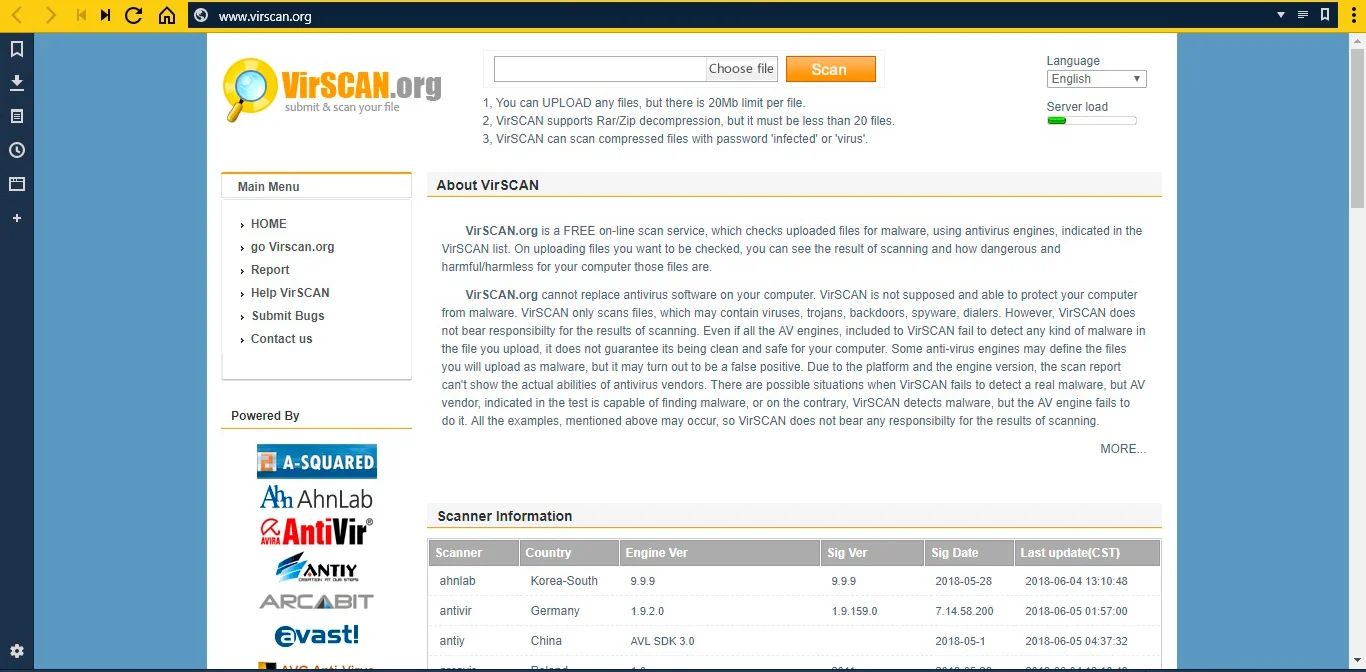

VirSCAN

Еще один неплохой инструмент для сканирования файлов несколькими антивирусными технологиями одновременно с возможностью выбора русскоязычного интерфейса. Доступна загрузка файлов размером до 20 Мб, пакетная проверка архивов Rar/Zip, содержащих до 20 файлов. Сканирование проводится известными и популярными антивирусами: Avira, Bitdefender, Kaspersky, ESET NOD32, McAfee, Comodo, Avast и др. Предусмотрен многопользовательский доступ. Процесс сканирования отслеживается в режиме онлайн в информативном окне.

Заключение

В данной статье мы провели небольшой обзор наиболее популярных бесплатных сервисов онлайн-проверки сайтов статическими и динамическими инструментами. Очевидно, что организовать стопроцентную защиту с использованием только одного из перечисленных ресурсов практически невозможно. Для предотвращения заражения и избежания негативных последствий следует использовать комплексную защиту. Чем более популярен и посещаем веб-ресурс, тем большее значение следует придавать его безопасности. Для обеспечения максимальной защиты стоит задуматься о приобретении платного антивирусного ПО, обладающего не только более расширенным функционалом проверки, но и обеспечивающего лечение и защиту сайтов.